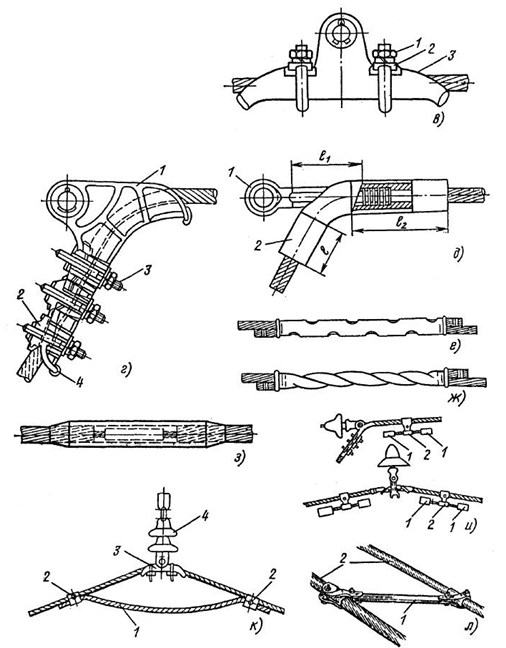

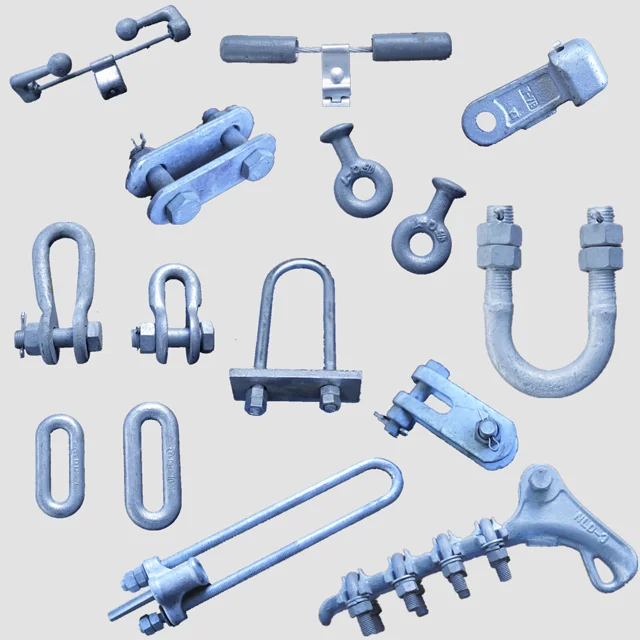

Линейная арматура: Каталог арматуры: защитная, подвесная, соединительная, сцепная

Содержание

АРМАТЕХ-НИЛЕД – Эксперт по арматуре СИП

+7 800 222‑26-68

142121, Московская область, г. Подольск, ул. Станционная, д. 24

+7 800 222‑26-68

Эксперт по арматуре СИП

Эксперт по арматуре СИП

Наша специализация

Продукция торговой марки

Аттестовано в ПАО РОССЕТИ

Продукция торговой марки

Аттестовано в ПАО РОССЕТИ

Продукция для работ под напряжением

Стороняя продукция

Наши контакты

+7 800 222‑26-68

info@n-sip. ru

ru

142121, Московская область, г. Подольск, ул. Станционная, д. 24

Навигация по сайту

Оставайтесь на связи

Vk

Youtube

Telegram

Tiktok

2003-2022 © АРМАТЕХ НИЛЕД — Эксперт по арматуре СИП — Арматура для СИП — линейная арматура СИП

Отправить заявку

Наименование компании *

ИНН *

ОГРН*

Ваш регион

Алтайский крайАмурская областьАрхангельская областьАстраханская областьБелгородская областьБрянская областьВладимирская областьВолгоградская областьВологодская областьВоронежская областьг. МоскваЕврейская автономная областьЗабайкальский крайИвановская областьИные территории, включая город и космодром БайконурИркутская областьКабардино-Балкарская РеспубликаКалининградская областьКалужская областьКамчатский крайКарачаево-Черкесская РеспубликаКемеровская областьКировская областьКостромская областьКраснодарский крайКрасноярский крайКурганская областьКурская областьЛенинградская областьЛипецкая областьМагаданская областьМосковская областьМурманская областьНенецкий автономный округНижегородская областьНовгородская областьНовосибирская областьОмская областьОренбургская областьОрловская областьПензенская областьПермский крайПриморский крайПсковская областьРеспублика Адыгея (Адыгея)Республика АлтайРеспублика БашкортостанРеспублика БурятияРеспублика ДагестанРеспублика ИнгушетияРеспублика КалмыкияРеспублика КарелияРеспублика КомиРеспублика КрымРеспублика Марий ЭлРеспублика МордовияРеспублика Саха (Якутия)Республика Северная Осетия — АланияРеспублика Татарстан (Татарстан)Республика ТываРеспублика ХакасияРостовская областьРязанская областьСамарская областьСанкт-ПетербургСаратовская областьСахалинская областьСвердловская областьСевастопольСмоленская областьСтавропольский крайТамбовская областьТверская областьТомская областьТульская областьТюменская областьУдмуртская РеспубликаУльяновская областьХабаровский крайХанты-Мансийский автономный округ — ЮграЧелябинская областьЧеченская РеспубликаЧувашская Республика — ЧувашияЧукотский автономный округЯмало-Ненецкий автономный округЯрославская областьКазахстан

Контактное лицо *

Телефон *

Сообщение

Я согласен на обработку персональных данных

Линейная арматура СИП 0,4 кВ/марки ВК

Отображение 1–24 из 91

По популярностиПо рейтингуСортировка от последнегоЦены: по возрастаниюЦены: по убыванию

Ответвительные герметичные зажимы для СИП-2 и СИП-4/ВК

(9)

Ответвительные зажимы с раздельной затяжкой болтов магистрального и ответвительного проводов/ВК

(3)

Плашечные зажимы/ВК

(7)

Анкерные кронштейны и крюки / ВК

(17)

Зажимы для крепления системы СИП без отдельного несущего элемента (СИП-4) / ВК

(19)

Изолированные наконечники, соединительные зажимы и модули / ВК

(35)

Анкерный абонентский кронштейн (CAP 25) — ВК

22,3 ₽В корзину

Анкерный абонентский кронштейн (CA 25) — ВК

39,0 ₽В корзину

Кожух малый (K-1)

71,0 ₽В корзину

Крюк с резьбой (BT 8)

72,0 ₽В корзину

Анкерный зажим для проводов ввода (PA 2/25 S)

75,6 ₽В корзину

Зажим плашечный (ПА-1-1)

83,0 ₽В корзину

Анкерный зажим для проводов ввода (PA 25 S)

90,0 ₽В корзину

Зажим анкерный для проводов ввода (DN 1)

98,4 ₽В корзину

Зажим плашечный (ПС-1-1А)

101,0 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 25) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 6-16) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 6-10) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 4-6) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 10-16) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 10) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 10-25) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 6) — ВК

112,8 ₽В корзину

Соединительный зажим для проводов ввода (MJPB 16) — ВК

112,8 ₽В корзину

Зажим плашечный (ПС-2-1А)

113,0 ₽В корзину

Зажим анкерный для проводов ввода (DN 123)

117,6 ₽В корзину

Зажим плашечный (ПС-1-1)

122,0 ₽В корзину

Ответвительный зажим (CT 25 P)

128,4 ₽В корзину

Ответвительный зажим (CT 16 A)

128,4 ₽В корзину

Зажим плашечный (ПС-2-1)

148,0 ₽В корзину

Линейная арматура СИП ВК

В настоящее время компания НИЛЕД осуществляет производство и сборку линейной арматуры СИП торговой марки НИЛЕД из европейских и отечественных комплектующих на базе собственного производственно-складского комплекса.

Линейная арматура СИП ВК производится компанией НИЛЕД из отечественных комплектующих на базе собственного завода в городе Подольске.

В состав комплекса входят производственная и офисная части, аккредитованная испытательная лаборатория, специально оборудованный учебный класс и различные полигоны для проведения обучающих мероприятий.

Линейная арматура СИП ВК и НИЛЕД аттестована в ПАО «Россети» и полностью удовлетворяет техническим требованиям других крупных электросетевых организаций.

Продукция полностью соответствует европейским стандартам CENELEC EN 50483, CENELEC EN 50397 и стандарту СТО ПАО «Россети». Подтверждением являются протоколы испытаний от аккредитованной лаборатории, имеющей соответствующую область аккредитации и заключения аттестационной комиссии ПАО «РОССЕТИ». Компания «НИЛЕД» предлагает не просто линейную арматуру СИП, а комплекс технических решений и сервиса для наших потребителей: технологические карты, типовые проекты, учебные фильмы по монтажу, программу для проектирования «ЛЭП ПРО», услуги по испытаниям на соответсвие НТД в аккредитованной лаборатории, услуги по проектированию линий ВЛИ, ВЛЗ.

Стоимость линейной арматуры СИП составляет 4—7% в строительстве на 1 км воздушных линий. При этом важность данного компонента в системе оборудования ВЛИ, ВЛЗ не меньше, чем других составляющих — провода, опор и т. д.

Рекомендуем запрашивать протоколы испытаний от испытательных центров, имеющих соответствующие области аккредитации для подтверждения заявленных характеристик.

Скачайте электронные версии:

- Каталога арматуры для СИП торговой марки НИЛЕД

- Каталога арматуры для СИП торговой марки ВК

- Брошюра по приемке продукции

Нилед2020 ВК2020

Понимание Q-обучения и аппроксимации линейной функции

класс, я хотел написать больше об обучении с подкреплением, поэтому в

в этом посте я дам несколько комментариев о Q-Learning и Linear Function.

Приближение. Я надеюсь, что эти сообщения могут послужить еще одним набором кратких RL

введения, похожие на отличный пост Андрея о глубоком RL.

В прошлом году я уже писал об основах MDP и RL. Этот

Этот

текущий служит продолжением этого, обсуждая, как масштабировать RL

в настройки, более сложные, чем простые табличные сценарии, но

далеко не так сложно, как, скажем, научиться играть в игры Atari от

высокоразмерный ввод. Я не буду тратить слишком много времени, пытаясь работать, хотя

Темы в этом посте, хотя. Я хочу сохранить свои усилия для глубокий сорт ,

который сейчас в моде и тема, которую я надеюсь в конечном итоге написать

много о для этого блога.

Чтобы помочь написать этот пост, вот две ссылки, которые я использовал для быстрого просмотра

Q-Learning с аппроксимацией функций.

- Учебное пособие по RL и аппроксиматорам линейных функций

- Книга RL Барто и Саттона в формате HTML

Я прочитал (1) полностью и (2) лишь частично, так как это все-таки целая книга

(обратите внимание, что авторы находятся в процессе создания нового издания!). Теперь давайте

перейти к обсуждению важной концепции: повторение значения с функцией

приближение . {(i)}\), мы выбираем очень маленькое подмножество

{(i)}\), мы выбираем очень маленькое подмножество

состояния \(S’ \подмножество S\) и вычислить официальную резервную копию Беллмана за один шаг

обновления: 92\]

, который можно выполнить, используя стандартные методы контролируемого обучения. Это, в

фактически, пример стохастического градиентного спуска.

Прежде чем двигаться дальше, стоит отметить очевидное: производительность Value

Итерация с аппроксимацией функции будет почти полностью зависеть от

качество признаков (наряду с представлением функции, т.е. линейным,

нейронная сеть и др.). Если вы программируете ИИ для игры в PacMan, состояния

\(s\) будет игровым полем, которое слишком многомерно для табличного представления.

представления. Черты идеально представляют что-то релевантно к

Производительность PacMan в игре, например, расстояние до ближайшего призрака,

расстояние до ближайшей пули, пойман ли PacMan и так далее. Не

пренебрегайте искусством и техникой выбора признаков!

Q-Learning с функциональной аппроксимацией

Итерация значения

с аппроксимацией функции — это хорошо, но, как я упоминал в своем

последний пост, то, что мы действительно хотим на практике, это значения \(Q(s,a)\) из-за

ключевой факт, что

\[\pi(s) = \arg_a \max Q^*(s,a)\]

, что позволяет избежать дорогостоящей суммы по штатам. Т \ фи (с, а) \]

Т \ фи (с, а) \]

Что в этом сложного, так это то, что обычно гораздо проще рассуждать

о функциях, которые являются только функциями состояний . Подумайте о PacMan

пример из предыдущего: относительно легко думать о функциях, просто

глядя на то, что находится на игровой сетке, но сложнее задаться вопросом, что происходит

к значению состояния при условии, что действие \(a\) имеет место .

По этой причине я предпочитаю использовать следующий «трюк с масштабированием измерения».

рекомендовано ссылкой (1) выше, что делает различие между

разные действия явные. Чтобы было понятно, представьте MDP с двумя функциями.

и четыре действия. Функции для пары состояние-действие \((s,a_i)\) могут быть закодированы

как:

\[\фи(с,а_1) =

\begin{bматрица}

\psi_1(s,a_1) \\

\psi_2(s,a_1) \\

0 \\

0 \\

0 \\

0 \\

0 \\

0 \\

1

\end{bmatrix}

,\четверка

\фи(с,а_2) =

\begin{bматрица}

0 \\

0 \\

\psi_1(s,a_2) \\

\psi_2(s,a_2) \\

0 \\

0 \\

0 \\

0 \\

1

\end{bmatrix}

,\четверка

\фи(с,а_3) =

\begin{bматрица}

0 \\

0 \\

0 \\

0 \\

\psi_1(s,a_3) \\

\psi_2(s,a_3) \\

0 \\

0 \\

1

\end{bmatrix}

,\четверка

\фи(с,а_4) =

\begin{bматрица}

0 \\

0 \\

0 \\

0 \\

0 \\

0 \\

\psi_1(s,a_4) \\

\psi_2(s,a_4) \\

1

\конец{bmatrix}\]

Зачем нужно использовать разные функции для разных действий? Интуитивно, если мы

не сделал этого (и сохранил \(\phi(s,a)\) всего с двумя непредвзятыми признаками), то

действие не будет иметь никакого эффекта! Но действия 9От 0005 до влияют на игру. Использовать

Использовать

снова пример PacMan, представьте, что у агента PacMan есть гранула для его

влево, так что агент находится в одном шаге от непобедимости. В то же время,

однако справа от Пакмана может быть призрак! Действие, которое выполняет PacMan

в этом состоянии (ВЛЕВО или ВПРАВО) окажет существенное влияние на результирующий

награда получена! Поэтому важно принимать во внимание действия, когда

показывая Q-значения.

Напоминаем, что прежде чем двигаться дальше, не забудьте термин смещения! они необходимы

правильно масштабировать значения функции независимо от признаков.

Онлайн-обоснование методом наименьших квадратов для Q-Learning

Теперь я хочу набросать вывод обновлений Q-Learning, чтобы обеспечить интуицию

почему это работает. Знание этого также важно для понимания того, как обучение

процесс работает для более продвинутого алгоритма/архитектуры Deep-Q-Network.

Вызов стандартного обновления Q-Learning без аппроксимации функции:

\[Q(s,a) \leftarrow (1-\alpha) Q(s,a) + \alpha \underbrace{[R(s,a,s’) + \gamma \max_{a’}Q(s ‘, а’)]} _ {\ rm образец} \]

9{(i)}\) в

итерация \(i\) алгоритма, и вы хотите выяснить, как его обновить. T\phi(s)\),

T\phi(s)\),

а затем применить описанный выше «трюк с масштабированием размеров», чтобы сделать

Q-Learning работает на практике.

строгое обоснование того, почему это имеет смысл, вместо того, чтобы полагаться на махание руками

аргументы.

Преимущество масштабируемости Q-Learning (или Value Iteration) с линейной функцией

приближение может звучать великолепно по сравнению с табличными версиями, но вот

критический вопрос: является аппроксиматором линейной функции, подходящим для

проблема ?

Это важно, потому что многие текущие исследования по обучению с подкреплением

применяется к сложным и многомерным данным. Отличный пример и

вероятно, самый популярный — научиться играть в игры Atari с нуля.

(210,160,3)-мерные массивы. Линейная функция просто неэффективна при

изучение значений \(Q(s,a)\) для этих задач, потому что проблемы

по своей сути нелинейный ! Дальнейшее обсуждение этого вопроса выходит за рамки

этот пост, но если вам интересно, Эндрю Нг обратился к этому в своем выступлении на

Школа глубокого обучения Bay Area месяц назад. Кевин Закка ведет хороший блог

Кевин Закка ведет хороший блог

сообщение, в котором резюмируется выступление Нг. 1 В режиме малых данных многие

алгоритмы могут достигать «хорошей» производительности с различиями, возникающими в больших

часть из-за того, кто больше настроил свой алгоритм, но в многомерном

режим больших данных, сложность модели имеет значение. Нейронные сети могут

изучать и представлять гораздо более сложные функции.

Поэтому в своем следующем посте я представлю и обсужу Q-Learning с помощью нейронных сетей.

сетей в качестве функции аппроксимации. Он будет использовать игры Atari в качестве

ходовой пример. Следите за обновлениями!

Здорово, что он это написал, потому что все ролики на ютубе с Нг

talk (на данный момент) не имеет включенной опции автозаголовков. Я не уверен

почему, и, несмотря на недостатки автозаголовков, это очень помогло бы.

Я попытался посмотреть выступление Нг и сдался через несколько минут, так как я был

не в состоянии понять слова, которые он говорил. ↩

↩

Включите JavaScript для просмотра комментариев с помощью Disqus.

Project

CS 542 Stat RL: Project Topics & References

(страница повторно используется и постоянно обновляется в течение нескольких семестров; ранее курс преподавался под номером 598)

Последнее обновление: 22.10.2022 30 Приближенное динамическое программирование и автономное RL Приблизительное динамическое программирование (ADP) касается получения приблизительных решений больших задач планирования, часто с помощью выборки и аппроксимации функций. Многие методы ADP можно рассматривать как прототипы популярных алгоритмов RL на основе значений, используемых сегодня, особенно в автономном режиме, поэтому важно понимать их поведение и гарантии. Автономное RL без исследовательских данных Нижние границы Оценка вне политики Как оценить эффективность политики, используя данные, собранные из другой политики? Этот вопрос имеет важные последствия для безопасности и реальных приложений RL. OPE в бандитах Выборка по важности для RL Выборка маргинальной важности и не только LSTD и LSPI Эти методы напрямую минимизируют спроецированную ошибку Беллмана для линейной аппроксимации функции цены и имеют некоторые другие характеристики по сравнению с другими методами TD, которые обучаются на бутстрепных целях. Multi-agent RL Онлайн Оффлайн POMDP и PSR Когда предположение Маркова не выполняется и мир частично наблюдаем, как вы можете восстановить состояние из наблюдений и спланировать, основываясь на убеждении ? Планирование Обучение Алгоритмы планирования на основе выборки Вычисление почти оптимальной политики в больших MDP путем выборки в генеративной модели среды. PAC-RL с аппроксимацией функций Ранг Беллмана и размерность Элудера Обнаружение латентного состояния Низкоранговые/линейные MDP Нижние границы PAC-RL (таблица) Нижние границы Использование дополнительной информации или структур в простых задачах Параллельный/»Низкий уровень переключения»/»Эффективный развертывание» PAC-RL Многозадачность и непрерывное обучение и обучение среди населения PAC Hierarchical RL Линейное программирование для MDP Помимо итерации значения/политики, еще одним стандартным методом решения MDP является линейное программирование (LP). Регуляризация энтропии RL на основе моделей с учетом решений RL и причинно-следственная связь В пакетном RL мы часто предполагаем, что регистрируемые действия являются функцией состояний, что не обязательно верно в некоторых сценариях приложений. Надежность в MDP Консервативный подход к MDP. Вычислите политику, устойчивую к неопределенности параметров MDP. Или, когда MDP полностью известен, вычислите политику, доходность которой оптимальна в наихудшем случае относительно. случайность траектории. Градиент политики и методы улучшения политики Как разработать алгоритм RL, который продолжает монотонно улучшать политику? Эта мотивация вдохновила первоначальный алгоритм CPI, а затем и его варианты, такие как TRPO. Интерактивное имитационное обучение Как имитировать политику на демонстрациях экспертов? Чистый подход к обучению с учителем («клонирование поведения») может страдать от сдвига распределения. Интерактивные методы, такие как DAgger, более устойчивы к нему. RL & Control В теории управления самой базовой моделью динамической среды является линейная система. Абстракции, RL на основе модели и выбор представления Абстракция состояния — это простейшая форма аппроксимации, которая сворачивает многомерное представление состояния в более управляемое. Понимание абстракций формирует основу для понимания более сложных схем аппроксимации функций. Однако разработка хорошей абстракции — очень сложная инженерная задача; можем ли мы сделать так, чтобы алгоритм автоматически выбирал среди представлений-кандидатов при обучении? Факторные MDP Факторированные MDP — это удобная формулировка крупномасштабных MDP: состояние представлено факторами, и будущее значение каждого фактора зависит только от значений небольшого числа родительских факторов в настоящее время.

Доказуемое обобщение в RL

Экзогенная информация

Эпизодическое обучение с подкреплением Формулировка LP также раскрывает много интересных свойств MDP (например, двойная формулировка имеет меру занятости в качестве переменных решения).

Формулировка LP также раскрывает много интересных свойств MDP (например, двойная формулировка имеет меру занятости в качестве переменных решения). Если действия в данных были определены на основе скрытых факторов, стандартные алгоритмы могут пострадать от эффекта смешения, и мы можем искать инструменты на основе причинно-следственного вывода, чтобы смягчить его.

Если действия в данных были определены на основе скрытых факторов, стандартные алгоритмы могут пострадать от эффекта смешения, и мы можем искать инструменты на основе причинно-следственного вывода, чтобы смягчить его.

Как сделать RL в непрерывном пространстве состояний и какие гарантии можно получить?

Как сделать RL в непрерывном пространстве состояний и какие гарантии можно получить?

Линейно-квадратичный регулятор: асимптотическая точка зрения

ru

ru