Модели станка: Классификация и расшифровка токарных станков

Содержание

Обозначение станков | Металлорежущие станки

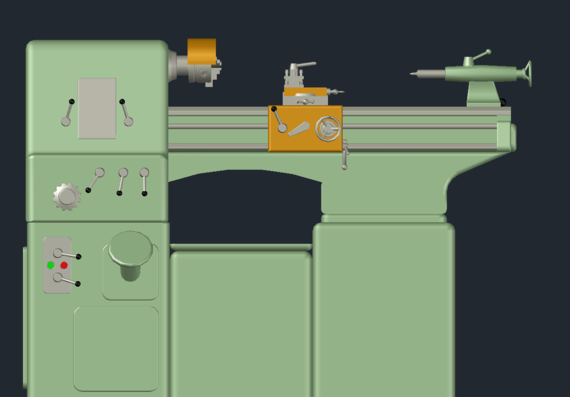

Каждый металлорежущий станок имеет условное обозначение — номер, по которому можно определить тип и краткую характеристику станка.

Группа станка

Первая цифра означает группу станка. Условились все токарные станки обозначать цифрой 1, группу сверлильных станков — цифрой 2, шлифовальные станки — цифрой 3, специальные станки — цифрой 4, зуборезные и резьбонарезные — цифрой 5, фрезерные — цифрой 6, строгальные, долбежные и протяжные — цифрой 7, разрезные — цифрой 8 и все остальные — цифрой 9.

Тип станка

Вторая цифра обозначает тип станка. Вертикально-фрезерные консольные станки имеют цифру 1, фрезерные непрерывного действия — цифру 2, копировальные, гравировальные — цифру 4, вертикальные бескоисольные — цифру 5, продольно-фрезерные — цифру 6, специальные консольно-фрезерные — цифру 7, горизонтально-фрезерные консольные — цифру 8, другие фрезерные — цифру 9.

Обозначение прочих характеристик

Третья цифра, а для крупных станков и четвертая цифра условно определяют основные размеры станка. Так, например, третья цифра 2 означает, что размер стола фрезерного станка равен 320×1250 мм. Станок 6662 (продольно-фрезерный) имеет стол размером 1800 x 6000 мм, у этого станка размеры стола обозначены двумя цифрами. Кроме цифр, в номер станка часто включают также различные буквы. Если буква стоит между первой и второй цифрами, это означает, что конструкция станка усовершенствована по сравнению с прежней моделью. Так, например, модель станка 682 совершенствовалась в течение многих лет, хотя основные размеры станка оставались почти одинаковыми. Эти более совершенные модели обозначали буквами Н, М, Р и др.

Так, например, третья цифра 2 означает, что размер стола фрезерного станка равен 320×1250 мм. Станок 6662 (продольно-фрезерный) имеет стол размером 1800 x 6000 мм, у этого станка размеры стола обозначены двумя цифрами. Кроме цифр, в номер станка часто включают также различные буквы. Если буква стоит между первой и второй цифрами, это означает, что конструкция станка усовершенствована по сравнению с прежней моделью. Так, например, модель станка 682 совершенствовалась в течение многих лет, хотя основные размеры станка оставались почти одинаковыми. Эти более совершенные модели обозначали буквами Н, М, Р и др.

Для обозначения быстроходного вертикально-фрезерного станка добавили букву Б (6Н12Б, 6М12Б, 6М12Р и т. н.). Буква в конце номера означает изменение основной или, как часто говорят, базовой модели. Если в номере станка есть буква Г, это означает, что станок горизонтально-фрезерный. В отличие от универсального станка, стол этого станка не поворачивается. Кроме станков, изготовляемых серийно, станкостроительные в а воды выпускают много специальных станков. Эти станки, как правило, обозначают условными заводскими номерами. Номер обычно заканчивается буквой К. Например, вертикально-фрезерный станок серии М с электрокопировальной следящей системой имеет обозначение 6М13К. В обозначения фрезерных станков, оснащенных системой циклового программного управления, включали букву П (например, станок 6А12П).

Эти станки, как правило, обозначают условными заводскими номерами. Номер обычно заканчивается буквой К. Например, вертикально-фрезерный станок серии М с электрокопировальной следящей системой имеет обозначение 6М13К. В обозначения фрезерных станков, оснащенных системой циклового программного управления, включали букву П (например, станок 6А12П).

Пример обозначения станка

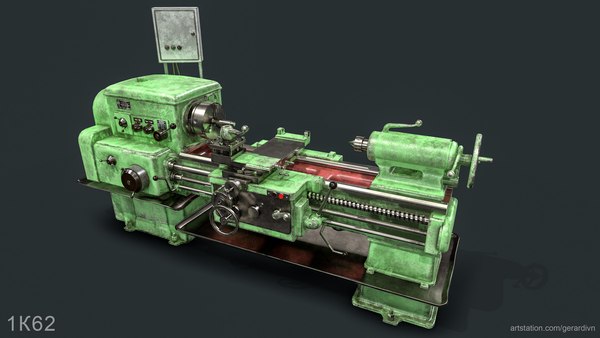

первая цифра 1 — , далее буква К — поколение станка, третья цифра 6 — означает что станок токарно — винторезный, четвертая цифра 2 — высота центров 220мм.

Обозначение станков с программным управлением

Для всех станков с программным управлением в обозначение (номер) станка вводят букву Ф, которая обозначает, что станок оснащен и цифра рядом с ней — дополнительный признак. Обозначение Ф1 применяют для станков, оборудованных устройствами цифровой индикации и предварительного набора координат. Устройство цифровой индикации имеет световое табло, на котором светящимися цифрами указывают значение координаты (длину перемещения исполнительного органа станка). По мере перемещения исполнительного органа происходит смена цифр на табло, и, таким образом, оператор или наладчик могут проверить в любой момент времени, какое перемещение, на какую длину выполнено.

По мере перемещения исполнительного органа происходит смена цифр на табло, и, таким образом, оператор или наладчик могут проверить в любой момент времени, какое перемещение, на какую длину выполнено.

Иногда система цифровой индикации сообщает, на каком режиме (с какой подачей, частотой вращения шпинделя) работает в данный момент станок, и выдает другую информацию. Обозначение Ф2 относится к станкам, оснащенным позиционными (независимо от того, движение по скольким координатам обеспечивает данная система управления). Обозначение ФЗ применяют для станков, оснащенных контурными системами ЧПУ, обеспечивающими автоматические перемещения исполнительного органа по двум или трем координатам (например, станок ). Обозначение Ф4 используют для станков с контурными или позиционными системами ЧПУ, которые имеют устройства для автоматической смены режущих инструментов.

Похожие материалы

Токарный станок с ЧПУ модели STL-750

|

Характеристика

|

Значение

|

|

Рабочая зона

| |

|

Наклон станины

|

30˚ к вертикали

|

|

Наибольший диаметр обработки над

|

650

|

|

Максимальный диаметр точения, мм

|

520

|

|

Стандартный диаметр точения, мм

|

350

|

|

Максимальная длина обработки (с патроном Ø315), мм

|

700

|

|

РМЦ, мм

|

750

|

|

Высота от фундамента до оси шпинделя, мм

|

1240

|

|

Расстояние от передней двери до оси шпинделя, мм

|

530

|

|

Размер патрона, мм

|

Ø315 / (Ø380)*

|

|

Сквозное отверстие в зажимном механизме патрона, мм

|

75

|

|

Главный шпиндель

| |

|

Отверстие в шпинделе, мм

|

90

|

|

Конус шпинделя

|

A2-11’’

|

|

Мощность шпинделя Siemens (S1/S6-30 мин), кВт

|

18/22

|

|

Мощность шпинделя Fanuc (S1/S6-30 мин), кВт

|

15/18 (18/22)*

|

|

Передний подшипник

|

170

|

|

Диапазон частот вращения шпинделя, об/мин.

|

50-1500

|

|

Максимальная мощность при оборотах, об/мин

|

500-1000

|

|

Перемещение по оси Х, мм

|

300

|

|

Перемещение по оси Z, мм

|

750

|

|

Скорость подачи

| |

|

Диапазон программируемых рабочих подач по осям X/ Z,

|

1…10 000

|

|

Быстрый ход по осям X/ Z, м/мин

|

15/15 (20/20)*

|

|

Максимальный крутящий момент приводов по осям X/ Z, Н*м

|

12/22

|

|

ШВП класс точности / диаметр / шаг по оси Z, мм

|

С3 / Ø50 / 10

|

|

ШВП класс точности / диаметр / шаг по оси X, мм

|

С3 / Ø32 / 8

|

|

Привод по оси Z

|

Ременной

|

|

Привод по оси Х

|

Прямой через муфту

|

|

Направляющие скольжения по оси Z, размеры, мм

|

40х80

|

|

Направляющие скольжения по оси Х, размеры, мм

|

32х60

|

|

Револьверная

| |

|

Модель

|

Pragati BTP

|

|

Количество позиций, шт

|

8 (12 )*

|

|

Размер резца, мм

|

25х25 (32×32)*

|

|

Макс.

|

40 (50)*

|

|

Задняя бабка

| |

|

Диаметр пиноли, мм

|

110 (120)*

|

|

Конус пиноли

|

МТ4

|

|

Ход

|

120

|

|

Перемещение

|

500

|

|

Точность

| |

|

Точность позиционирования, мм

|

0,01

|

|

Повторяемость позиционирования, мм

|

±0,005

|

|

Макс.шероховатость обрабатываемых поверхностей

|

Ra

|

|

Система СОЖ

| |

|

Объем бака, л

|

160

|

|

Производительность насоса, л/мин

|

85

|

|

Мощность двигателя насоса, кВт

|

0,25

|

|

Мощность двигателя стружкоуборочного транспортера, кВт

|

0,38

|

|

Гидростанция

| |

|

Объем бака, л

|

50

|

|

Марка масла

|

Servo

|

|

Давление, bar

|

50

|

|

Мощность двигателя, кВт

|

2,2

|

|

Масса-габаритные

| |

|

Габариты (LxBxH)не более , мм

|

3000x2000x2150

|

|

Масса, не более, кг

|

8000

|

|

Система ЧПУ

|

FANUC /

|

Объяснение всех моделей машинного обучения за 6 минут | Теренс Шин

Интуитивное объяснение самых популярных моделей машинного обучения.

Если вы хотите протестировать эти алгоритмы машинного обучения, ознакомьтесь с Saturn Cloud , масштабируемой и гибкой платформой для анализа данных с бесплатным и корпоративным уровнями.

В своей предыдущей статье я объяснил, что такое регрессия , и показал, как ее можно использовать в приложении. На этой неделе я расскажу о большинстве распространенных моделей машинного обучения, используемых на практике, чтобы у меня было больше времени на построение и улучшение моделей, а не на объяснение лежащей в их основе теории. Давайте углубимся в это.

Фундаментальная сегментация моделей машинного обучения

Все модели машинного обучения классифицируются как контролируемые или неконтролируемые . Если модель является моделью с учителем, она подразделяется либо на модель регрессии , либо на модель классификации . Ниже мы рассмотрим, что означают эти термины и соответствующие модели, которые попадают в каждую категорию.

Ниже мы рассмотрим, что означают эти термины и соответствующие модели, которые попадают в каждую категорию.

Обязательно подпишитесь здесь или на мой эксклюзивный информационный бюллетень , чтобы не пропустить ни одной статьи о руководствах по науке о данных, хитростях и советах, жизненных уроках и многом другом!

Обучение под наблюдением включает в себя изучение функции, которая отображает ввод в вывод на основе примеров пар ввода-вывода [1].

Например, если бы у меня был набор данных с двумя переменными, возрастом (входная) и ростом (выходная), я мог бы реализовать модель контролируемого обучения для прогнозирования роста человека на основе его возраста.

Пример контролируемого обучения

Повторим еще раз: в контролируемом обучении есть две подкатегории: регрессия и классификация.

В моделях регрессии вывод является непрерывным. Ниже приведены некоторые из наиболее распространенных типов регрессионных моделей.

Линейная регрессия

Пример линейной регрессии

Идея линейной регрессии заключается в простом поиске линии, которая лучше всего соответствует данным. Расширения линейной регрессии включают множественную линейную регрессию (например, поиск плоскости наилучшего соответствия) и полиномиальную регрессию (например, поиск кривой наилучшего соответствия). Вы можете узнать больше о линейной регрессии в моей предыдущей статье.

Дерево решений

Изображение взято с Kaggle

Деревья решений — популярная модель, используемая в исследованиях операций, стратегическом планировании и машинном обучении. Каждый квадрат выше называется узлом , и чем больше у вас узлов, тем более точным будет ваше дерево решений (как правило). Последние узлы дерева решений, в которых принимается решение, называются листьями дерева. Деревья решений интуитивно понятны и просты в построении, но им не хватает точности.

Деревья решений интуитивно понятны и просты в построении, но им не хватает точности.

Если вы хотите протестировать эти алгоритмы машинного обучения, ознакомьтесь с Saturn Cloud — масштабируемой и гибкой платформой для анализа данных с бесплатным и корпоративным уровнями.

Случайный лес

Случайный лес — это метод ансамблевого обучения, основанный на деревьях решений. Случайные леса включают создание нескольких деревьев решений с использованием наборов исходных данных с начальной загрузкой и случайным выбором подмножества переменных на каждом шаге дерева решений. Затем модель выбирает режим всех прогнозов каждого дерева решений. Какой в этом смысл? Полагаясь на модель «победы большинства», она снижает риск ошибки из-за отдельного дерева.

Например, если бы мы создали одно дерево решений, третье дерево предсказывало бы 0. Но если бы мы полагались на режим всех 4 деревьев решений, предсказанное значение было бы 1. Это сила случайных лесов.

Но если бы мы полагались на режим всех 4 деревьев решений, предсказанное значение было бы 1. Это сила случайных лесов.

StatQuest проделал потрясающую работу, подробно изучив этот вопрос. Глянь сюда.

Нейронная сеть

Визуальное представление нейронной сети

Нейронная сеть по существу является сетью математических уравнений. Он принимает одну или несколько входных переменных и, проходя через сеть уравнений, получает одну или несколько выходных переменных. Вы также можете сказать, что нейронная сеть принимает вектор входных данных и возвращает вектор выходных данных, но в этой статье я не буду углубляться в матрицы.

Синие кружки представляют входной слой , черные кружки представляют скрытых слоев, и зеленые кружки представляют выходной слой . Каждый узел в скрытых слоях представляет как линейную функцию, так и функцию активации, через которую проходят узлы в предыдущем слое, что в конечном итоге приводит к результату в зеленых кругах.

- Если вы хотите узнать больше об этом, ознакомьтесь с моим объяснением нейронных сетей для начинающих.

Обязательно на ЗДЕСЬ или на мою Эксклюзивные информационные бюллетени более!

В моделях классификации выходные данные являются дискретными. Ниже приведены некоторые из наиболее распространенных типов моделей классификации.

Логистическая регрессия

Логистическая регрессия похожа на линейную регрессию, но используется для моделирования вероятности конечного числа результатов, обычно двух. Существует ряд причин, по которым логистическая регрессия используется вместо линейной регрессии при моделировании вероятностей результатов (см. здесь). По сути, логистическое уравнение создается таким образом, что выходные значения могут быть только между 0 и 1 (см. ниже).

Если вы хотите протестировать эти алгоритмы машинного обучения, ознакомьтесь с Saturn Cloud — масштабируемой и гибкой платформой для анализа данных с бесплатным и корпоративным уровнями.

Машина опорных векторов

Машина опорных векторов — это метод контролируемой классификации, который на самом деле может быть довольно сложным, но довольно интуитивно понятным на самом фундаментальном уровне.

Предположим, что есть два класса данных. Машина опорных векторов найдет гиперплоскость или граница между двумя классами данных, которая максимизирует разницу между двумя классами (см. ниже). Есть много плоскостей, которые могут разделить два класса, но только одна плоскость может максимизировать запас или расстояние между классами.

Если вы хотите углубиться в детали, Саван написал здесь отличную статью о машинах опорных векторов.

Наивный Байес

Наивный Байес — еще один популярный классификатор, используемый в науке о данных. Идея, лежащая в основе этого, основана на теореме Байеса:

Говоря простым языком, это уравнение используется для ответа на следующий вопрос. «Какова вероятность y (моя выходная переменная) при заданном X? И из-за наивного предположения, что переменные независимы для данного класса, вы можете сказать, что:

«Какова вероятность y (моя выходная переменная) при заданном X? И из-за наивного предположения, что переменные независимы для данного класса, вы можете сказать, что:

Кроме того, убрав знаменатель, мы можем сказать, что P(y|X) пропорционально правой части.

Таким образом, цель состоит в том, чтобы найти класс y с максимальной пропорциональной вероятностью.

Посмотрите мою статью « Математическое объяснение наивного Байеса ” если вы хотите более подробное объяснение!

Дерево решений, Случайный лес, Нейронная сеть

Эти модели следуют той же логике, что и ранее. Единственное отличие состоит в том, что этот вывод является дискретным, а не непрерывным.

В отличие от обучения с учителем, обучение без учителя используется для создания выводов и поиска закономерностей из входных данных без ссылок на помеченные результаты. Два основных метода, используемых в неконтролируемом обучении, включают кластеризацию и уменьшение размерности.

Если вы хотите протестировать эти алгоритмы машинного обучения, ознакомьтесь с Saturn Cloud — масштабируемой и гибкой платформой для анализа данных с бесплатным и корпоративным уровнями.

Взято из GeeksforGeeks

Кластеризация — это неконтролируемый метод, который включает группировку или кластеризацию точек данных. Он часто используется для сегментации клиентов, обнаружения мошенничества и классификации документов.

Общие методы кластеризации включают кластеризацию k-средних , иерархическую кластеризацию , кластеризацию среднего сдвига и кластеризацию на основе плотности. Хотя у каждого метода есть свой метод поиска кластеров, все они направлены на достижение одной и той же цели.

Снижение размерности — это процесс уменьшения числа рассматриваемых случайных величин путем получения набора главных переменных [2]. Проще говоря, это процесс уменьшения размерности вашего набора функций (еще проще говоря, уменьшения количества функций). Большинство методов уменьшения размерности можно разделить на 9 категорий.Удаление признаков 0008 или извлечение признаков .

Проще говоря, это процесс уменьшения размерности вашего набора функций (еще проще говоря, уменьшения количества функций). Большинство методов уменьшения размерности можно разделить на 9 категорий.Удаление признаков 0008 или извлечение признаков .

Популярный метод уменьшения размерности называется анализом главных компонентов.

Анализ основных компонентов (АГК)

В самом простом смысле, АПК включает проецирование данных более высокого измерения (например, 3 измерения) в меньшее пространство (например, 2 измерения). Это приводит к более низкому измерению данных (2 измерения вместо 3 измерений) при сохранении всех исходных переменных в модели.

Здесь довольно много математики. Если вы хотите узнать об этом больше…

Прочтите эту замечательную статью о PCA здесь.

Если вы предпочитаете смотреть видео, StatQuest объясняет PCA за 5 минут здесь.

Если вы хотите протестировать эти алгоритмы машинного обучения, ознакомьтесь с Saturn Cloud — масштабируемой и гибкой платформой для анализа данных с бесплатным и корпоративным уровнями.

Обязательно ПОДПИСАТЬСЯ здесь , чтобы никогда не пропустить новую статью о руководствах по науке о данных, хитростях и советах, жизненных уроках и многом другом!

Надеюсь, вам было интересно и познавательно. Дайте мне знать, какая ваша любимая визуализация данных за 2022 год в комментариях!

Не знаете, что читать дальше? Я подобрал для вас еще одну статью:

БОЛЕЕ 100 вопросов и ответов на собеседовании с Data Scientist!

Вопросы для интервью от Amazon, Google, Facebook, Microsoft и других компаний!

в направлении datascience.com

или вы можете проверить мою страницу на Medium:

Terence Shin — Medium

Прочтите письмо Теренса Шина на Medium. Наука о данных @ KOHO, SaturnCloud | MSc, MBA |…

terenceshin. medium.com

medium.com

- Fellow @ SaturnCloud

- ПОДПИСАТЬСЯ на мой Medium

- СЛЕДУЙТЕ за мной на Medium

- Следуйте за мной в LinkedIn

Модели машинного обучения | Топ-5 удивительных моделей машинного обучения

Модель машинного обучения является результатом процесса обучения и определяется как математическое представление реального процесса. Алгоритмы машинного обучения находят шаблоны в обучающем наборе данных, который используется для аппроксимации целевой функции и отвечает за сопоставление входных данных с выходными из доступного набора данных. Эти методы машинного обучения зависят от типа задачи и классифицируются как модели классификации, модели регрессии, кластеризация, уменьшение размерности, анализ главных компонентов и т. д.

Типы моделей машинного обучения

В зависимости от типа задач модели машинного обучения можно разделить на следующие типы:

- Классификационные модели

- Модели регрессии

- Кластеризация

- Уменьшение размерности

- Глубокое обучение и т.

д.

д.

1) Классификация

Применительно к машинному обучению классификация — это задача предсказания типа или класса объекта в пределах конечного числа вариантов. Выходная переменная для классификации всегда является категориальной переменной. Например, определение того, является ли электронное письмо спамом, является стандартной задачей бинарной классификации. Теперь давайте отметим некоторые важные модели для задач классификации.

- Алгоритм K-ближайших соседей — простой, но исчерпывающий в вычислительном отношении.

- Наивный Байес — основан на теореме Байеса.

- Логистическая регрессия — линейная модель для бинарной классификации.

- SVM — может использоваться для бинарной/мультиклассовой классификации.

- Дерево решений — ‘ If Else ’ Классификатор на основе, более устойчивый к выбросам.

- Ансамбли — комбинация нескольких моделей машинного обучения, объединенных вместе для получения лучших результатов.

2) Регрессия

В машине регрессия обучения представляет собой набор задач, в которых выходная переменная может принимать непрерывные значения. Например, прогнозирование стоимости авиабилетов можно рассматривать как стандартную задачу регрессии. Отметим некоторые важные модели регрессии, используемые на практике.

- Линейная регрессия — простейшая базовая модель для задачи регрессии, хорошо работает, только когда данные линейно разделимы и мультиколлинеарность очень мала или отсутствует.

- Регрессия Лассо — Линейная регрессия с регуляризацией L2.

- Регрессия хребта — линейная регрессия с регуляризацией L1.

- Регрессия SVM

- Регрессия дерева решений и т. д.

3) Кластеризация

Проще говоря, кластеризация — это задача группировки похожих объектов вместе. Это помогает идентифицировать похожие объекты автоматически без ручного вмешательства. Мы не можем создавать эффективные модели машинного обучения с учителем (модели, которые необходимо обучать с помощью отобранных вручную или помеченных данных) без однородных данных. Кластеризация помогает нам достичь этого более разумным способом. Ниже приведены некоторые из широко используемых моделей кластеризации:

Кластеризация помогает нам достичь этого более разумным способом. Ниже приведены некоторые из широко используемых моделей кластеризации:

- K означает — простой, но с высокой дисперсией.

- K означает++ — Модифицированная версия K означает.

- К медоиды.

- Агломеративная кластеризация — модель иерархической кластеризации.

- DBSCAN — алгоритм кластеризации на основе плотности и т. д.

4) Уменьшение размерности

Размерность — это количество переменных-предикторов, используемых для прогнозирования независимой переменной или цели. Часто в реальных наборах данных количество переменных слишком велико. Слишком много переменных также навлекают на модели проклятие переобучения. На практике среди этого большого количества переменных не все переменные в равной степени способствуют достижению цели, и в большом количестве случаев мы действительно можем сохранить дисперсии с меньшим количеством переменных. Перечислим некоторые часто используемые модели уменьшения размерности.

- PCA — создает меньшее количество новых переменных из большого количества предикторов. Новые переменные независимы друг от друга, но менее интерпретируемы.

- TSNE — обеспечивает встраивание точек данных более высокого измерения в более низкое измерение.

- SVD — Разложение по единственному значению используется для разложения матрицы на более мелкие части для эффективного расчета.

5) Глубокое обучение

Глубокое обучение — это подмножество машинного обучения, связанное с нейронными сетями. Основываясь на архитектуре нейронных сетей, давайте перечислим важные модели глубокого обучения:

- Многослойный персептрон

- Сверточные нейронные сети

- Рекуррентные нейронные сети

- Машина Больцмана

- Автоэнкодеры и т. д.

Какая модель лучше?

Выше мы рассмотрели множество моделей машинного обучения. Теперь нам приходит на ум очевидный вопрос: «Какая из этих моделей является лучшей?» Это зависит от рассматриваемой проблемы и других связанных с ней атрибутов, таких как выбросы, объем доступных данных, качество данных, проектирование признаков и т. д. всегда предпочтительнее начинать с самой простой модели, применимой к проблеме, и постепенно увеличивать сложность путем правильной настройки параметров и перекрестной проверки. В мире науки о данных есть пословица: «Перекрестная проверка заслуживает большего доверия, чем знание предметной области».

д. всегда предпочтительнее начинать с самой простой модели, применимой к проблеме, и постепенно увеличивать сложность путем правильной настройки параметров и перекрестной проверки. В мире науки о данных есть пословица: «Перекрестная проверка заслуживает большего доверия, чем знание предметной области».

Как построить модель?

Давайте посмотрим, как построить простую модель логистической регрессии с помощью библиотеки Python Scikit Learn. Для простоты мы предполагаем, что проблема представляет собой стандартную модель классификации, а «train.csv» — это поезд, а «test.csv» — данные поезда и теста соответственно.

Заключение

В этой статье обсуждались важные модели машинного обучения, используемые для практических целей, и как построить простую модель в Python. Выбор правильной модели для конкретного варианта использования очень важен для получения правильного результата задачи машинного обучения. Чтобы сравнить производительность между различными моделями, метрики оценки или ключевые показатели эффективности определяются для конкретных бизнес-задач, а лучшая модель выбирается для производства после применения статистической проверки производительности.

(бесступенчатое

(бесступенчатое

диаметр установки инструмента круглого сечения, мм

диаметр установки инструмента круглого сечения, мм