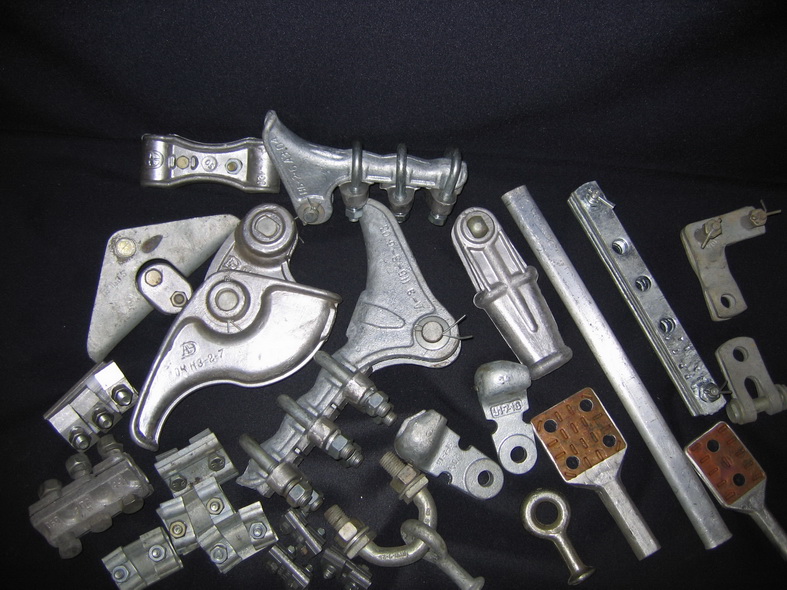

Линейная арматура: Линейная арматура для ВЛ и ЛЭП аттестованного производителя

Содержание

Линейная арматура для ЛЭП — ООО ЭНЕРГЕТИК-1

Главная страница — Линейная арматура

Представлено 11 товаров

Исходная сортировкаПо популярностиСортировка от последнегоЦены: по возрастаниюЦены: по убыванию

12/24/48/Все

- Featured

2ПР-16-1

Цена по запросу

Добавить в корзину2ПР-16-1

Промежуточное звено 2ПР-16-1 предназначено для удлинения изоляторных подвесок на воздушных линий электропередач (ВЛ). Представляет из себя устройство из двух металлических пластин с проушинами на концах скрепленных между собой соединительными пальцами с болтовым креплением и шплинтовой фиксацией.

Цена по запросу

ВС 120/150.2

Цена по запросу

Добавить в корзинуВС 120/150.2

Вязка спиральная ВС 120/150.2 предназначена для крепления защищенного провода СИП-3 к штыревым и опорным изоляторам.

Цена по запросу

КГ-21-3 Узел крепления

Цена по запросу

Добавить в корзинуКГ-21-3 Узел крепления

КГ-21-3 Узел крепления натяжных и поддерживающих изолирующих подвесок к опорам ВЛ и распределительных устройств.

Цена по запросу

- Featured

НБ-2-6А

Цена по запросу

Добавить в корзинуНБ-2-6А

НБ-2-6А Зажим болтовой натяжной

Цена по запросу

РДИМ-10-1,5-IV-УХЛ1

Цена по запросу

Добавить в корзинуРДИМ-10-1,5-IV-УХЛ1

Разрядник РДИМ-10-1,5-IV-УХЛ1 устройство для защиты ВЛ от прямых ударов молнии и от индуктированных грозовых перенапряжений.

Цена по запросу

РДИП-10-4-УХЛ1/001

Цена по запросу

Добавить в корзинуРМК-20-IV-УХЛ1

Цена по запросу

Добавить в корзинуРМК-20-IV-УХЛ1

РМК-20-IV УХЛ1 – мультикамерный разрядник обеспечивает стабильную работу высоковольтных линий от 6 до 20 кВ при грозовых перенапряжениях.

Цена по запросу

- Featured

СК-21-1а

Цена по запросу

Добавить в корзинуСК-21-1а

Соединительная скоба СК-21-1а, применяется для образования цепного шарнирного соединения «проушина-палец» для крепления гирлянд изоляторов шарнирным методом и для крепления грозозащитных тросов.

Цена по запросу

СКД-21-1

Цена по запросу

Добавить в корзинуСКД-21-1

СКД-21-1 специальная соединительная скоба, применяется для образования цепного шарнирного соединения непосредственно на соединение «проушина-палец» для крепления гирлянд изоляторов и грозозащитных тросов.

Цена по запросу

СРС-7-16

Цена по запросу

Добавить в корзинуСРС-7-16

Серьга CPC-7-16 для изолирующих подвесок высоковольтных линий электропередач.

Цена по запросу

У1-7-16 Ушко

Цена по запросу

Добавить в корзинуУ1-7-16 Ушко

У1-7-16 Ушко однолапчатое для соединения стержня подвесного изолятора или серьги с другой линейной арматурой.

Цена по запросу

12/24/48/Все

Линейная арматура

В рамках программы импортозамещения с 2010 г. освоено серийное производство новой линейной арматуры (зажимов) для строительства ВЛИ-0,4 кВ с проводами СИП-4и. Новые зажимы прошли все необходимые испытания и имеют декларации о соответствии Таможенного союза.

освоено серийное производство новой линейной арматуры (зажимов) для строительства ВЛИ-0,4 кВ с проводами СИП-4и. Новые зажимы прошли все необходимые испытания и имеют декларации о соответствии Таможенного союза.

Зажим поддерживающий промежуточный ЗПП

Предназначен для промежуточного крепления СИП-4и за все провода одновременно на промежуточных и угловых промежу-точных опорах при угле поворота до 30°. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Разрушающая нагрузка не менее 6 кН, масса не более 0,375 кг. Срок службы не менее 25 лет.

Зажим концевой натяжной ЗКН-1

Предназначен для концевого (анкерного) крепления СИП-4и за все силовые провода одновременно на концевых анкерных и угловых анкерных опорах ВЛИ-0,4 кВ. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Номинальное сечение закрепляемого провода – 50-95 мм2. Разрушающая на-грузка не менее 27 кН, масса не более 1,1 кг. Срок службы не менее 25 лет.

Зажим концевой натяжной ЗКН-2

Предназначен как для концевого (анкерного) крепления СИП-4и за все силовые провода одновременно, так и для промежуточного (поддерживающего) крепления ВЛИ-0,4 кВ. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Номинальное сечение закрепляемого провода – 16-35 мм2. Разрушающая нагрузка не менее 14,5 кН, масса не более 0,52 кг. Срок службы не менее 25 лет.

Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Номинальное сечение закрепляемого провода – 16-35 мм2. Разрушающая нагрузка не менее 14,5 кН, масса не более 0,52 кг. Срок службы не менее 25 лет.

Зажим переходной влагозащищённый ЗПВ

Предназначен для электрического соединения изолированных проводов СИП напряжением 0,4 кВ с неизолированными металлическими проводниками ответвлений путём прокола изоляции жилы СИП и создания контакта с неизолированным ответвительным проводником; для соединения изолированных проводов (нулевой жилы) с неизолированными нулевыми жилами и заземляющими проводниками. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Сечение соединяемых проводников — 16-95 мм2, масса не более 0,18 кг. Срок службы не менее 25 лет.

Зажим ответвительный прокалывающий герметичный зопг-1

Предназначен для электрического соединения изолированных проводов ВЛИ-0,4 кВ с изолированными проводами ответвлений путём прокола изоляции. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Магистрали 16-95 мм2, ответвления 16-95 мм2, массой не более 0,18 кг. Срок службы не менее 25 лет.

Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Магистрали 16-95 мм2, ответвления 16-95 мм2, массой не более 0,18 кг. Срок службы не менее 25 лет.

Зажим ответвительный прокалывающий герметичный зопг-2

Предназначен для электрического соединения изолированных проводов ВЛИ-0,4 кВ с изолированными проводами ответвлений путём прокола изоляции. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Магистрали 16-95 мм2, ответвления 4,0-35 мм2, массой не более 0,13 кг. Срок службы не менее 25 лет.

Зажим ответвительный прокалывающий герметичный зопг-3

Предназначен для электрического соединения изолированных фонарного и нулевого проводов ВЛИ-0,4 кВ с соответствующими изолированными проводами питания светильника уличного освещения, а также для электрического соединения изолированных проводов при выполнении электрических вводов в здания и сооружения (абонентские ответвления) путём прокола изоляции. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Магистрали 16-95 мм2, ответвления 2,5-6,0 мм2, массой не более 0,1 кг. Срок службы не менее 25 лет.

Магистрали 16-95 мм2, ответвления 2,5-6,0 мм2, массой не более 0,1 кг. Срок службы не менее 25 лет.

Зажим грозозащитный зг-10

Предназначен для отвода электрического разряда при атмосферных перенапряжениях (при ударах молнии) на ВЛП. Может использоваться для выполнения ответвлений от ВЛП неизолированных проводов ВЛ (6-20 кВ). Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. ТУ РБ 00114241.011-98.

Зажим ответвительный прокалывающий ЗОП-10

Предназначен для выполнения присоединения к проводам ВЛП проводов ответвлений, покрытых изолирующей оболочкой, путём прокалывания изолирующей оболочки зажимом. Климатическое исполнение УХЛ категории размещения 1 по ГОСТ 15150. Номинальное сечение соединяемых проводов ВЛП – 35-120 мм2. ТУ РБ 00114241.011-98.

Понимание Q-обучения и аппроксимации линейной функции

класс, я хотел написать больше об обучении с подкреплением, поэтому в

в этом посте я дам несколько комментариев о Q-Learning и Linear Function.

Приближение. Я надеюсь, что эти сообщения могут послужить еще одним набором кратких RL

введения, похожие на отличный пост Андрея о глубоком RL.

В прошлом году я уже писал об основах MDP и RL. Этот

текущий служит продолжением этого, обсуждая, как масштабировать RL

в настройки, более сложные, чем простые табличные сценарии, но

далеко не так сложно, как, скажем, научиться играть в игры Atari от

высокоразмерный ввод. Я не буду тратить слишком много времени, пытаясь работать, хотя

Темы в этом посте, хотя. Я хочу сохранить свои усилия для глубокий сорт ,

который сейчас в моде и тема, которую я надеюсь в конечном итоге написать

много о для этого блога.

Чтобы помочь написать этот пост, вот две ссылки, которые я использовал для быстрого просмотра

Q-Learning с аппроксимацией функций.

- Учебное пособие по RL и аппроксиматорам линейных функций

- Книга RL Барто и Саттона в формате HTML

Я прочитал (1) полностью и (2) лишь частично, так как это все-таки целая книга

(обратите внимание, что авторы находятся в процессе создания нового издания!). {(i)}\), мы выбираем очень маленькое подмножество

{(i)}\), мы выбираем очень маленькое подмножество

состояния \(S’ \подмножество S\) и вычислить официальную резервную копию Беллмана за один шаг

обновления: 92\]

, который можно выполнить, используя стандартные методы контролируемого обучения. Это, в

фактически, пример стохастического градиентного спуска.

Прежде чем двигаться дальше, стоит отметить очевидное: производительность Value

Итерация с аппроксимацией функции будет почти полностью зависеть от

качество признаков (наряду с представлением функции, т.е. линейным,

нейронная сеть и др.). Если вы программируете ИИ для игры в PacMan, состояния

\(s\) будет игровым полем, которое слишком многомерно для табличного представления.

представления. Черты идеально представляют что-то релевантно к

Производительность PacMan в игре, например, расстояние до ближайшего призрака,

расстояние до ближайшей пули, пойман ли PacMan и так далее. Не

пренебрегайте искусством и техникой выбора признаков!

Q-Learning с функциональной аппроксимацией

Итерация значения

с аппроксимацией функции — это хорошо, но, как я упоминал в своем

последний пост, то, что мы действительно хотим на практике, это значения \(Q(s,a)\) из-за

ключевой факт, что

\[\pi(s) = \arg_a \max Q^*(s,a)\]

, что позволяет избежать дорогостоящей суммы по штатам. Т \ фи (с, а) \]

Т \ фи (с, а) \]

Что в этом сложного, так это то, что обычно гораздо проще рассуждать

о функциях, которые являются только функциями состояний . Подумайте о PacMan

пример из предыдущего: относительно легко думать о функциях, просто

глядя на то, что находится на игровой сетке, но сложнее задаться вопросом, что происходит

к значению состояния при условии, что действие \(a\) имеет место .

По этой причине я предпочитаю использовать следующий «трюк с масштабированием измерения».

рекомендовано ссылкой (1) выше, что делает различие между

разные действия явные. Чтобы было понятно, представьте MDP с двумя функциями.

и четыре действия. Функции для пары состояние-действие \((s,a_i)\) могут быть закодированы

как:

\[\фи(с,а_1) =

\begin{bматрица}

\psi_1(s,a_1) \\

\psi_2(s,a_1) \\

0 \\

0 \\

0 \\

0 \\

0 \\

0 \\

1

\end{bmatrix}

,\четверка

\фи(с,а_2) =

\begin{bmatrix}

0 \\

0 \\

\psi_1(s,a_2) \\

\psi_2(s,a_2) \\

0 \\

0 \\

0 \\

0 \\

1

\end{bmatrix}

,\четверка

\фи(с,а_3) =

\begin{bmatrix}

0 \\

0 \\

0 \\

0 \\

\psi_1(s,a_3) \\

\psi_2(s,a_3) \\

0 \\

0 \\

1

\end{bmatrix}

,\четверка

\фи(с,а_4) =

\begin{bmatrix}

0 \\

0 \\

0 \\

0 \\

0 \\

0 \\

\psi_1(s,a_4) \\

\psi_2(s,a_4) \\

1

\конец{bmatrix}\]

Зачем нужно использовать разные функции для разных действий? Интуитивно, если мы

не сделал этого (и сохранил \(\phi(s,a)\) всего с двумя непредвзятыми признаками), то

действие не будет иметь никакого эффекта! Но действия 9От 0005 до влияют на игру. Использовать

Использовать

снова пример PacMan, представьте, что у агента PacMan есть гранула для его

влево, так что агент находится в одном шаге от непобедимости. В то же время,

однако справа от Пакмана может быть призрак! Действие, которое выполняет PacMan

в этом состоянии (ВЛЕВО или ВПРАВО) окажет существенное влияние на результирующий

награда получена! Поэтому важно принимать во внимание действия, когда

показывая Q-значения.

Напоминаем, что прежде чем двигаться дальше, не забудьте термин смещения! они необходимы

правильно масштабировать значения функции независимо от признаков.

Онлайн-обоснование методом наименьших квадратов для Q-Learning

Теперь я хочу набросать вывод обновлений Q-Learning, чтобы обеспечить интуицию

почему это работает. Знание этого также важно для понимания того, как обучение

процесс работает для более продвинутого алгоритма/архитектуры Deep-Q-Network.

Вызов стандартного обновления Q-Learning без аппроксимации функции:

\[Q(s,a) \leftarrow (1-\alpha) Q(s,a) + \alpha \underbrace{[R(s,a,s’) + \gamma \max_{a’}Q(s ‘, а’)]} _ {\ rm образец} \]

9{(i)}\) в

итерация \(i\) алгоритма, и вы хотите выяснить, как его обновить. T\phi(s)\),

T\phi(s)\),

а затем применить описанный выше «трюк с масштабированием размеров», чтобы сделать

Q-Learning работает на практике.

строгое обоснование того, почему это имеет смысл, вместо того, чтобы полагаться на махание руками

аргументы.

Преимущество масштабируемости Q-Learning (или Value Iteration) с линейной функцией

приближение может звучать великолепно по сравнению с табличными версиями, но вот

критический вопрос: является аппроксиматором линейной функции, подходящим для

проблема ?

Это важно, потому что многие текущие исследования по обучению с подкреплением

применяется к сложным и многомерным данным. Отличный пример и

вероятно, самый популярный — научиться играть в игры Atari с нуля.

(210,160,3)-мерные массивы. Линейная функция просто неэффективна при

изучение значений \(Q(s,a)\) для этих задач, потому что проблемы

по своей сути нелинейный ! Дальнейшее обсуждение этого вопроса выходит за рамки

этот пост, но если вам интересно, Эндрю Нг обратился к этому в своем выступлении на

Школа глубокого обучения Bay Area месяц назад. Кевин Закка ведет хороший блог

Кевин Закка ведет хороший блог

сообщение, в котором резюмируется выступление Нг. 1 В режиме малых данных многие

алгоритмы могут достигать «хорошей» производительности с различиями, возникающими в больших

часть из-за того, кто больше настроил свой алгоритм, но в многомерном

режим больших данных, сложность модели имеет значение. Нейронные сети могут

изучать и представлять гораздо более сложные функции.

Поэтому в своем следующем посте я представлю и обсужу Q-Learning с помощью нейронных сетей.

сетей в качестве функции аппроксимации. Он будет использовать игры Atari в качестве

ходовой пример. Следите за обновлениями!

Здорово, что он это написал, потому что все ролики на ютубе с Нг

talk (на данный момент) не имеет включенной опции автозаголовков. Я не уверен

почему, и, несмотря на недостатки автозаголовков, это очень помогло бы.

Я попытался посмотреть выступление Нг и сдался через несколько минут, так как я был

не в состоянии понять слова, которые он говорил. ↩

↩

Включите JavaScript для просмотра комментариев с помощью Disqus.

Доказуемо эффективное обучение с подкреплением с приближением линейной функции

Чи Джин, Чжуоран Ян, Чжаоран Ван, Майкл Джордан

Труды тридцать третьей конференции по теории обучения , PMLR 125:2137-2143, 2020.

Аннотация

Современное обучение с подкреплением (RL) обычно применяется к практическим задачам с огромным количеством состояний, где \emph{аппроксимация функции} должна быть развернута для аппроксимации либо функции ценности, либо политики. Введение аппроксимации функций поднимает фундаментальный набор проблем, связанных с вычислительной и статистической эффективностью, особенно учитывая необходимость управления компромиссом между разведкой и эксплуатацией. В результате основной вопрос RL остается открытым: как мы можем разработать доказуемо эффективные алгоритмы RL, которые включают аппроксимацию функций? Этот вопрос сохраняется даже в базовой настройке с линейной динамикой и линейным вознаграждением, для которого требуется только аппроксимация линейной функции. 3T}) $ сожаление, где $d$ — окружающее измерение пространства признаков, $H$ — длина каждого эпизода, а $T$ — общее количество шагов. Важно отметить, что такое сожаление не зависит от количества состояний и действий.

3T}) $ сожаление, где $d$ — окружающее измерение пространства признаков, $H$ — длина каждого эпизода, а $T$ — общее количество шагов. Важно отметить, что такое сожаление не зависит от количества состояний и действий.

Процитировать эту статью

БибТекс

@InProceedings{pmlr-v125-jin20a,

title = {Доказуемо эффективное обучение с подкреплением с приближением линейной функции},

автор = {Цзинь, Чи и Ян, Чжоран и Ван, Чжаоран и Джордан, Майкл I},

booktitle = {Материалы тридцать третьей конференции по теории обучения},

страницы = {2137--2143},

год = {2020},

редактор = {Абернети, Джейкоб и Агарвал, Шивани},

громкость = {125},

серия = {Материалы исследования машинного обучения},

месяц = {09--12 июля},

издатель = {PMLR},

pdf = {http://proceedings.mlr.press/v125/jin20a/jin20a.pdf},

URL = {https://proceedings.mlr.press/v125/jin20a.html},

abstract = { Современное обучение с подкреплением (RL) обычно применяется к практическим задачам с огромным количеством состояний, где \emph{аппроксимация функции} должна быть развернута для аппроксимации либо функции ценности, либо политики. 3T}) $ сожаление, где $d$ — окружающее измерение пространства признаков, $H$ — длина каждого эпизода, а $T$ — общее количество шагов. Важно отметить, что такое сожаление не зависит от количества состояний и действий. }

3T}) $ сожаление, где $d$ — окружающее измерение пространства признаков, $H$ — длина каждого эпизода, а $T$ — общее количество шагов. Важно отметить, что такое сожаление не зависит от количества состояний и действий. }

}

Сноска

%0 Документ конференции

%T Доказуемо эффективное обучение с подкреплением с аппроксимацией линейной функции

%А Чи Джин

%A Чжоран Ян

%A Чжаоран Ван

%A Майкл I Джордан

%B Труды тридцать третьей конференции по теории обучения

%C Материалы исследования машинного обучения

%D 2020

%E Джейкоб Абернети

%E Шивани Агарвал

%F пмлр-v125-jin20a

%I PMLR

%P 2137--2143

%U https://proceedings.mlr.press/v125/jin20a.html

%V 125

%X Современное обучение с подкреплением (RL) обычно применяется к практическим задачам с огромным количеством состояний, где \emph{аппроксимация функции} должна быть развернута для аппроксимации либо функции ценности, либо политики. Введение аппроксимации функций поднимает фундаментальный набор проблем, связанных с вычислительной и статистической эффективностью, особенно учитывая необходимость управления компромиссом между разведкой и эксплуатацией.