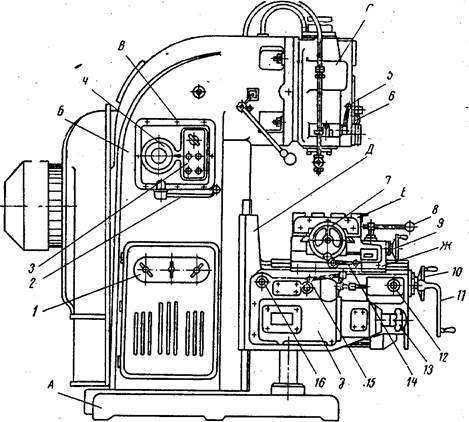

Вм 127м технические характеристики: ВМ127М технические характеристики | Станок фрезерный вертикальный с УЦИ

Содержание

ВМ127М технические характеристики | Станок фрезерный вертикальный с УЦИ

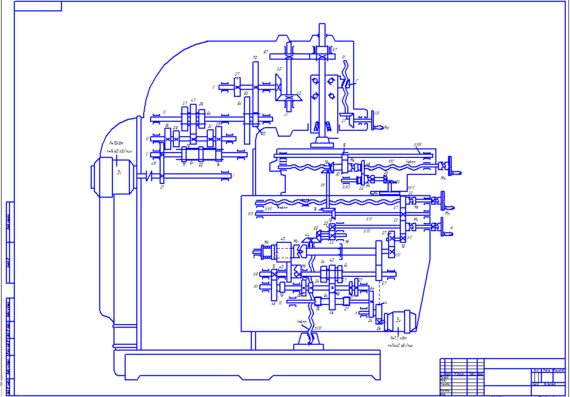

Технические характеристики фрезерного станка ВМ127М реализуют возможность механической обработки деталей из чугуна методом фрезерования.

Наименование характеристики | Ед. изм. | Параметры |

Класс точности по ГОСТ 8-82 |

| Н |

Стол | ||

Размеры рабочей поверхности стола (Д х Ш) | мм | 1600 х 400 |

Число Т-образных пазов |

| 3 |

Перемещение стола |

|

|

продольное (Х) | мм | 1010 |

поперечное (Y) | мм | 320 |

вертикальное (Z) | мм | 420 |

Количество подач стола |

| 18 |

Пределы подач стола |

|

|

Продольных | мм/мин | 25…1250 |

Поперечных | мм/мин | 25…1250 |

Вертикальных | мм/мин | 8,3…416,6 |

Расстояния от торца шпинделя до стола | мм | 30…500 |

Расстояние от оси шпинделя до вертикальных направляющих станины | мм | 420 |

Скорость быстрого перемещения стола |

|

|

Продольного и поперечного | мм/мин | 3000 |

Вертикального | мм/мин | 1000 |

Наибольшая масса обрабатываемой детали (с приспособлениями) | кг | 300 |

Перемещение стола на одно деление лимба |

|

|

продольное, поперечное | мм | 0,05 |

вертикальное | мм | 0,05 |

Перемещение стола на один оборот лимба |

|

|

продольное | мм | 4 |

поперечное | мм | 6 |

вертикальное | мм | 2 |

Шпиндель | ||

Количество ступеней скоростей шпинделя |

| 18 |

Внутренний конус шпинделя |

| 50 |

Частота вращения шпинделя | об/мин | 40…2000 |

Наибольшее осевое перемещение пиноли шпинделя | мм | 80 |

Перемещение пиноли на один оборот лимба | мм | 4 |

Перемещение пиноли на одно деление лимба | мм | 0,05 |

Наибольший угол поворота шпиндельной головки | град | ±45 |

Механика станка | ||

Выключающие упоры подачи |

| Есть |

Блокировка ручной и механической подач |

| Есть |

Блокировка рукояток |

| Есть |

Блокировка раздельного включения подачи |

| Есть |

Автоматическая прерывная подача |

|

|

продольная |

| Есть |

поперечная и вертикальная |

| Нет |

Торможение шпинделя |

| Есть |

Предохранение от перегрузки (муфта) |

| Есть |

Электрооборудование | ||

Количество электродвигателей на станке (с электронасосом) |

| 4 |

Главный привод станка |

|

|

Мощность | кВт | 11 |

Электродвигатель привода подач |

|

|

Мощность | кВт | 2,1 |

Электронасос подачи охлаждающей жидкости |

|

|

Мощность | кВт | 0,12 |

Тип |

| П-32МС10 |

Производительность | л/мин | 22 |

Электродвигатель зажима инструмента |

|

|

Тип |

| АИР56В2У3 |

Габариты и масса | ||

Габаритные размеры станка |

|

|

длина | мм | 2560 |

ширина | мм | 2260 |

высота | мм | 2500 |

Масса станка | кг | 4250 |

Цена на вертикально-фрезерный станок вм127м

Цена на 05. 10.2022

10.2022

Под заказ

Производитель:

Россия

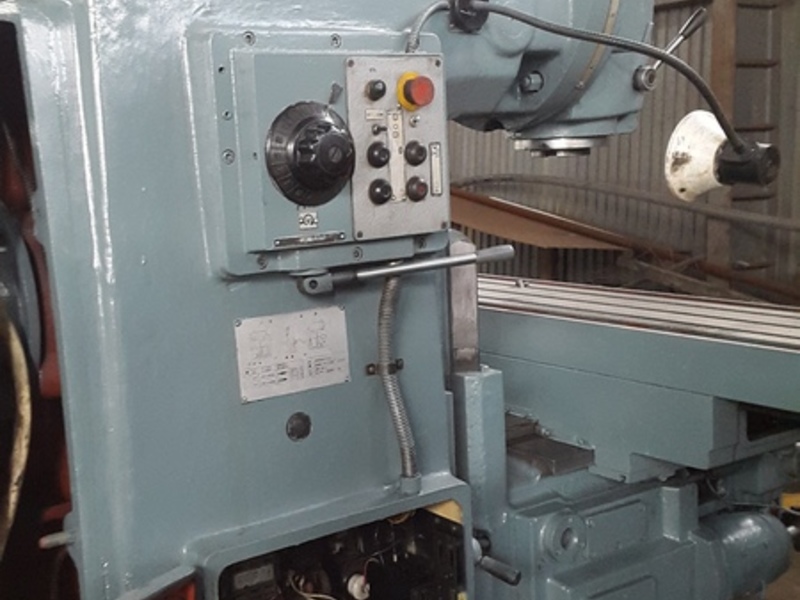

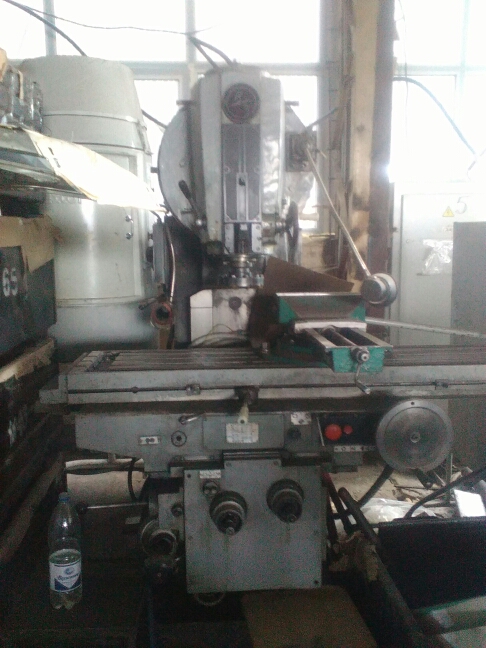

Вертикальные фрезерные машины востребованы предприятиями, занимающимися выпуском деталей, изделий, конструкций в серийном масштабе. Покупка фрезерного станка вм127м обеспечит возможность оперативно осуществлять качественное формирование фрез разной формы на деталях из цветных и черных металлических сплавов.

С помощью вертикально фрезерного станка вм127 можно нарезать не только прямолинейные фрезы с простым и фасонным сечением, но и винтовые фаски, для создания которых агрегат оборудован поворотным столом.

- Благодаря варьированию величины передаваемой приводом энергии создаются условия для полноценного использования всего диапазона технических возможностей вертикально фрезерного станка вм127.

- Простая конструкция позволяет в краткие сроки проводить переналадку и смену оснастки, не вызывают затруднений освоение, эксплуатация и обслуживание.

- Смазка рабочих систем и узлов осуществляется автоматически, что существенно продлевает срок безупречной работоспособности фрезерной машины.

Немалым достоинством является стоимость, предложенная нашей фирмой за фрезерный станок вм 127 – цена производительного оборудования быстро окупится при рациональной нагрузке.

ТЕХНИЧЕСКИЕ ХАРАКТЕРИСТИКИ ФРЕЗЕРНОГО СТАНКА ВМ127М

|

Характеристика |

ВМ127М |

|---|---|

|

Размеры рабочей поверхности стола (ширина х длина), мм |

400 х 1600 |

|

Число Т-образных пазов |

3 |

|

Максимальная нагрузка на стол (по центру), кг |

800 |

|

Наибольшее перемещение стола, мм: | |

|

— продольное механическое/ручное |

1010/1010 |

|

— поперечное механическое/ручное |

300(280)/320 |

|

— вертикальное механическое/ручное |

400/420 |

|

Перемещение стола на одно деление лимба (продольное поперечное, вертикальное), мм |

0,05 |

|

Перемещение стола на один оборот лимба, мм: | |

|

— продольное |

4 |

|

— поперечное |

6 |

|

— вертикальное |

2 |

|

Точность линейных координатных перемещений стола (при оснащении БЦИ) , мкм: | |

|

— продольное (координата “Х”) |

50 |

|

— поперечное ( координата “Y”) |

50 |

|

— вертикальное (координата “Z”) |

50 |

|

Конус шпинделя |

АТ50 |

|

Наибольшее перемещение пиноли шпинделя, мм |

80 |

|

Наибольшее и наименьшее перемещение от торца шпинделя до рабочей | |

|

поверхности стола при ручном перемещении, мм |

30-500* |

|

Расстояние от оси шпинделя до вертикальных направляющих станины, мм |

420 |

|

Угол поворота шпиндельной головки, град.

|

±45 |

|

Количество скоростей шпинделя |

18 |

|

Пределы бесступенчатой регулировки скорости подач, мм/мин : | |

|

— продольной рабочая/ускоренная |

25-1250/3000 |

|

— поперечной рабочая/ускоренная |

25-1250/3000 |

|

— вертикальной рабочая/ускоренная |

8,3-416,6/1000 |

|

Мощность электродвигателей, кВт: | |

|

— главного движения |

11 |

|

— привода подач |

2,1 |

|

Мощность электронасоса охлаждающей жидкости, к Вт |

0,12 |

|

Производительность электронасоса охлаждающей жидкости, л/мин |

22 |

|

Класс точности станка |

Н |

|

Габариты, мм |

2560х2260х2500 |

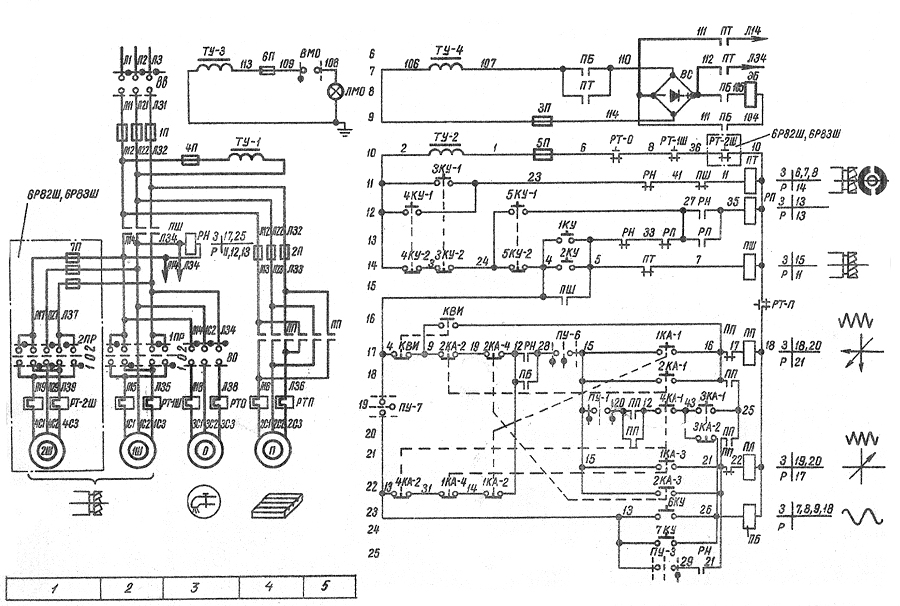

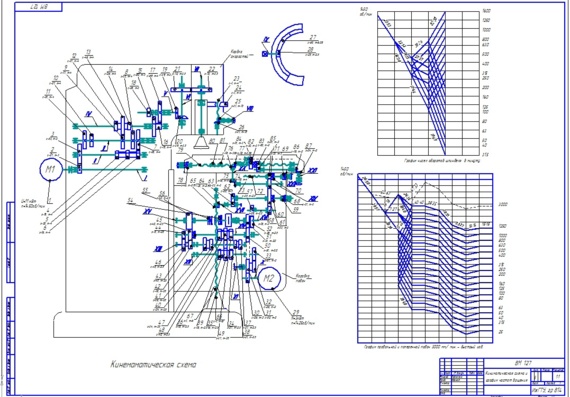

Цветная электросхема фрезерного станка ВМ 127М

Собрать электрическую схему своими руками совсем несложно, если вы обладаете должным уровнем знаний по электротехнике, даже отличным знанием электротехники.

Как ы понимаете это дело не для новичков и тех, кто не понимает ничего в электрических схемах. Разберем этапы работы на примере фрезерного станка и узнаем что такое принципиальная электрическая схема фрезерного станка.

Включение, выключение и торможение шпинделя

Для включения шпинделя необходимо нажать кнопку SB7, включаются пускатель KM1 и реле времени KT1, KT2. Пускатель KM1 подает напряжение 380 В на двигатель M1, а KT2 своими замыкающими контактами блокирует выключатель SB7.

Для выключения шпинделя необходимо нажать кнопку SB4, отключаются пускатель KM1 и реле времени KT1, KT2. Через 1, 2 с включится пускатель K2, который своими замыкающими контактами включит динамическое торможение шпинделя. Через 5, 6 с замыкающие контакты реле времени KT2 выключают пускатель K2, а K2 соответственно отключит динамическое торможение шпинделя.

Электропривод подач

Электропривод подач представляет собой электромеханическую систему. Включение и отключение подачи осуществляется рукоятками, которые имеют три фиксированных положения, а также выключателями SQ6, SQ8 для продольной; SQ5, SQ7 для вертикальной или поперечной подачи.

Включение и отключение подачи осуществляется рукоятками, которые имеют три фиксированных положения, а также выключателями SQ6, SQ8 для продольной; SQ5, SQ7 для вертикальной или поперечной подачи.

Быстрый ход подачи происходит при нажатии кнопки SB9, включается пускатель K3 и электромагнит быстрого хода YA. На станке электрической блокировкой исключается возможность одновременного включения продольной и поперечной или вертикальной подачи.

Принцип действия

Принцип действия основан на отображении работы каких-либо конечных приемников электрической энергии от работы или взаимодействия остальных компонентов, входящий в данную принципиальную электрическую схему фрезерного станка.

На нашем примере — это отработка магнитных пускателей в зависимости от положения рукояток управления, положения концевых выключателей, состояния тепловых реле и т. п.

Принципиальная электрическая схема управления ЭП вертикально-фрезерного станка

Функциональное назначение

KM1 — подключает напряжение 380 В к приводу главного движения M1 и двигателю насоса охлаждения M2; KM2, KM3 — подключают напряжение 380 В к приводу подач M3; KM4, KM5 — подключают напряжение 380 В к двигателю механизма крепления инструмента; K2 — включает динамическое торможение шпинделя; K3 — включает быстрый ход привода подач и импульсное включение привода главного движения при переключении скоростей шпинделя; K5 — подготавливает цепь включения привода главного движения после зажима инструмента: KT1 — задает время вращения шпинделя после его выключения до включения торможения. KT2 — задает время торможения шпинделя; QF1 — вводной выключатель; QS2 — переключатель насоса охлаждения; SQ3 — выключатель импульсного включения привода подач при переключении скоростей; SQ5, SQ7 — выключатель привода стола «вперед-назад» и «вверх-вниз»; SQ6, SQ8 — выключатель привода стола «влево-вправо»; SQ10 — выключатель блокировки главного движения и подач при зажиме инструмента.

KT2 — задает время торможения шпинделя; QF1 — вводной выключатель; QS2 — переключатель насоса охлаждения; SQ3 — выключатель импульсного включения привода подач при переключении скоростей; SQ5, SQ7 — выключатель привода стола «вперед-назад» и «вверх-вниз»; SQ6, SQ8 — выключатель привода стола «влево-вправо»; SQ10 — выключатель блокировки главного движения и подач при зажиме инструмента.

Зажим инструмента

Для зажима инструмента необходимо тумблер SA3 (на боковом пульте) установить в положение «Зажим» и удерживать рукой. При этом срабатывает пускатель КМ4, который подает напряжение на двигатель механизма зажима инструмента М4. Идет зажим инструмента. Прощелкивание муфты в механизме зажима свидетельствует об окончании зажима инструмента. Микровыключатель SQ10 своими контактами включает пускатель К5.1, который становится на самопитание, отключает двигатель М4 и подготовит цепь пуска двигателя шпинделя.

Разжим инструмента: тумблер SA3 установить в положение «Разжим» и удерживать рукой. При этом срабатывают пускатели КМ5.1. Пускатель КМ5.3. подает напряжение на двигатель М4. Идет отжим инструмента. Окончание отжима инструмента контролируется визуально. Примечание: Во избежание получения травм при разжиме инструмента пуск шпинделя блокируется замыкающими контактами К5 При вращающемся шпинделе разжим инструмента заблокирован размыкающими контактами К5 в цепи включения двигателя М4 При зажиме и разжиме инструмента, с целью исключения проворачивания шпинделя, необходимо установить низкую скорость оборотов шпинделя (не выше 400об/мин)

При этом срабатывают пускатели КМ5.1. Пускатель КМ5.3. подает напряжение на двигатель М4. Идет отжим инструмента. Окончание отжима инструмента контролируется визуально. Примечание: Во избежание получения травм при разжиме инструмента пуск шпинделя блокируется замыкающими контактами К5 При вращающемся шпинделе разжим инструмента заблокирован размыкающими контактами К5 в цепи включения двигателя М4 При зажиме и разжиме инструмента, с целью исключения проворачивания шпинделя, необходимо установить низкую скорость оборотов шпинделя (не выше 400об/мин)

Фрезерный станок для производства рекламы с ЧПУ

Особенности 1. Фрезерный станок для производства рекламы SK1218 имеет современный дизайн. Наш фрезерный станок для производства рекламы отличается высокой точностью работы, высокой жёсткостью и низким уровнем производственных ошибок. 2. Наш фрезерный станок имеет совершенную конструкцию с шариковым винтом высокой точности и мощным диском, что позволило добиться очень высокой точности гравировки. 3. Наш фрезерные станок для производства рекламы с ЧПУ SK1218 удобен в обслуживании. В своей конструкции, он использует модульную структуру, которая позволяет гарантировать быструю разборку и сборку станка, что значительно облегчает ремонтные работы. 4. Основные конструкционные детали нашего станка произведены иностранными компаниями, что позволяет гарантировать их качество.

3. Наш фрезерные станок для производства рекламы с ЧПУ SK1218 удобен в обслуживании. В своей конструкции, он использует модульную структуру, которая позволяет гарантировать быструю разборку и сборку станка, что значительно облегчает ремонтные работы. 4. Основные конструкционные детали нашего станка произведены иностранными компаниями, что позволяет гарантировать их качество.

Применение Фрезерный станок для производства рекламы с ЧПУ SK1218 имеет широкую сферу применения, например, используется в процессе производства рекламных щитов, при строительных работах, при резки акрила, при термическом формировании моделей, при изготовлении изделий из дерева и т.д. Наш фрезерный станок для производства рекламы может обрабатывать железо, медь, алюминий, пластик и многие другие материалы.

Технические параметры фрезерного станка для производства рекламы SK1218 Модель Фрезерный станок SK1218 Рабочая зона XY 1200*1800мм Рабочая зона Z 80мм Мотор шпинделя 1.5кВт или 2.2кВт Рабочий режим Шаговый Система управления DSP или PCI система контроля Точность позиционирования 0. 02/300мм Точность перемещения 0.01мм Мак. скорость 0 — 4,000мм/мин Мак.высота подачи 120мм Программное обеспечение Тип 3, ArtCAM, NC Studio Гравирующий инструмент G код x, u00 x, mmg x, plt Движение X Y Шариковый винт Операционное напряжение AC220В/ 50-60Гц Операционная температура 0-45º Операционная влажность 35%-70% Вес нетто 550кг Размер упаковки 250*175*150см

02/300мм Точность перемещения 0.01мм Мак. скорость 0 — 4,000мм/мин Мак.высота подачи 120мм Программное обеспечение Тип 3, ArtCAM, NC Studio Гравирующий инструмент G код x, u00 x, mmg x, plt Движение X Y Шариковый винт Операционное напряжение AC220В/ 50-60Гц Операционная температура 0-45º Операционная влажность 35%-70% Вес нетто 550кг Размер упаковки 250*175*150см

Электропривод подач

Электропривод подач представляет собой электромеханическую систему. Включение и отключение подачи осуществляется рукоятками, которые имеют три. фиксированных положения, а также выключателями SQ6, SQ8 для продольной; SQ5, SQ7 для вертикальной или поперечной подачи.

Быстрый ход подачи происходит при нажатии кнопки SВ9, включается пускатель КЗ и электромагнит быстрого хода УА. На станке электрической блокировкой исключается возможность одновременного включения продольной и поперечной или вертикальной подачи.

Виды

Различают такие виды электросхем:

- структурная, которая определяет взаимосвязь частей электрооборудования;

- функциональная, определяющая электрические процессы в отдельном узле, полностью для чпу станка;

- принципиальная, в которой отражены все элементы, дается представление относительно принципа работы;

- соединения монтажного плана для подключений к электросети;

- расположения частей электроустройств, проводниковой и кабельной продукции.

Техническая документация устройства обычно содержит принципиальную электросхему и схемы расположения электрооборудования. Ее выполняют, не придерживаясь масштаба и не указывая, как в действительности расположены отдельные элементы.

Регулировка цепи торможения шпинделя

Регулировка цепи торможения производится после замены или ремонта реле времени КТ1, КТ2, а также в случае, когда временные характеристики цепи торможения не соответствуют указанным в п. 7.6.5.

Для проведения регулировки необходимо: подать питание на станок включить шпиндель

Одновременно с выключателем шпинделя включить секундомер и остановить его при срабатывании К2. Если зафиксированное время превышает I сек., повернуть регулятор реле времени КТ1 по часовой стрелке. Повторить включение и выключение шпинделя, добиваясь включения пускателя К2 через 1 сек. Если пускатель К2 срабатывает менее , чем 1 сек. после отключения шпинделя, тогда регулятор реле КТ1 повернуть против часовой стрелки. Регулировку реле КТ2 проводить аналогично КТ1. Выключить шпиндель станка, одновременно с нажатием кнопки SB4, запустить секундомер и остановить его после остановки шпинделя. Зафиксированное время не Должно быть более 6 сек.

Регулировку реле КТ2 проводить аналогично КТ1. Выключить шпиндель станка, одновременно с нажатием кнопки SB4, запустить секундомер и остановить его после остановки шпинделя. Зафиксированное время не Должно быть более 6 сек.

Мини фрезерный станок с ЧПУ

Разрезание различных материалов с помощью движущей фрезы производится на фрезерных станках, которые представлены многими видами. Это горизонтальный, широкоуниверсальный, консольный вертикальный, безконсольный, продольный станок. Управление на них производится вручную, автоматизировано с помощью Числового программного обеспечения (ЧПУ). Станки, имеющие ЧПУ, отличаются высокой скоростью, точностью изготовления деталей. При работе на фрезерном станке с ЧПУ на обработку детали требуется значительно меньше времени, чем при работе на аналогах с ручным или автоматизированным управлением.

Мини фрезерный станок с ЧПУФрезерование корпусов металлических деталей на мелкосерийном производстве, в ремонтных мастерских, при выпуске деталей небольших размеров, в автосервисах, школьных мастерских нет необходимости иметь стационарный фрезерный станок. Вполне подойдет мини фрезерный станок с ЧПУ. Это настольный станок, имеющий прекрасные технические характеристики и приемлемую в сравнении с другими станками цену. Они имеют небольшие габариты, просты в конструкции. При установке такого станка не требуется прокладывать усиленный кабель для электропитания. Станку требуется питание 220В, а не 380В.

Вполне подойдет мини фрезерный станок с ЧПУ. Это настольный станок, имеющий прекрасные технические характеристики и приемлемую в сравнении с другими станками цену. Они имеют небольшие габариты, просты в конструкции. При установке такого станка не требуется прокладывать усиленный кабель для электропитания. Станку требуется питание 220В, а не 380В.

Мини фрезерный станок с ЧПУНебольшой станок дает возможность качественно выполнять раскрой материала, изготавливать изделия сложной плоской и пространственной формы. Человеческий фактор уходит на последнее место, так как вся работа ведется на основе программ.

Мини фрезерный станок с ЧПУ выполняется с достаточно жесткой станиной, с точными узлами привода для устранения люфтов и зазоров. Материалы на изготовление ходовой части используют износоустойчивые.

Система электронного оборудования защищает работающего от возможных ошибок, как неправильная последовательность или иная ошибка предупреждается подачей звукового оповещающего сигнала. Поэтому брак при работе практически исключен. Станки с ЧПУ оснащены системой, которая заранее просматривает процесс, проводит анализ, при необходимости сокращает движение. Мини фрезерный станок с ЧПУАвтоматическая система, поддерживающая двойной проход, позволяет добиться высокого качества при работе с МДФ, пластиком. Пакетная обработка повышает отдачу при работе с партиями изделий. При этом значительно сокращается время. Для небольших мастерских, гаражей подойдет мини фрезерный станок с ЧУП со стандартной комплектацией. Размеры рабочего поля стола обычно имеют от 300х300, 400х400, 600х900 миллиметров.

Поэтому брак при работе практически исключен. Станки с ЧПУ оснащены системой, которая заранее просматривает процесс, проводит анализ, при необходимости сокращает движение. Мини фрезерный станок с ЧПУАвтоматическая система, поддерживающая двойной проход, позволяет добиться высокого качества при работе с МДФ, пластиком. Пакетная обработка повышает отдачу при работе с партиями изделий. При этом значительно сокращается время. Для небольших мастерских, гаражей подойдет мини фрезерный станок с ЧУП со стандартной комплектацией. Размеры рабочего поля стола обычно имеют от 300х300, 400х400, 600х900 миллиметров.

Фрезерная и токарная обработка в Москве

Токарная обработка – это процесс механической обработки цилиндрических поверхностей деталей резанием. При токарной обработке режущий инструмент совершает линейно-поступательные движения, сама же заготовка – вращательное движение. Основные виды токарной обработки: обточка наружных и внутренних цилиндрических, конических и фасонных поверхностей, растачивание, прорезание канавок, нарезание резьбы, торцевание, сверление, зенкерование и другие. Режущим инструментом служат резцы, сверла, зенкера.

Режущим инструментом служат резцы, сверла, зенкера.

Фрезерная обработка – это процесс механической обработки деталей, при котором режущий инструмент совершает вращательное движение, а обрабатываемая заготовка – поступательное. Существует два основных вида фрезерования: цилиндрическое и торцовое. Фрезерную обработку применяют для плоского и фасонного строгания кромок изделия, формирования прямых и винтовых канавок, нарезания резьбы, шлиц, зубчатых колес, сверлильных и расточных работ. Режущим инструментом служат различные виды фрез, прорезные диски, плоские ножи.

Мы предлагаем широкий спектр услуг по фрезерной и токарной обработке металлов: токарные и фрезерные работы, сверление, растачивание, нарезание резьбы, зубчатых колес, вырубку контура, вытачивание канавок, шлифовку, обработку внутренней поверхности, а также продольно-строгальную обработку крупногабаритных заготовок и другие работы.

Наше оборудование

На нашем производстве используется парк универсальных металлообрабатывающих станков:

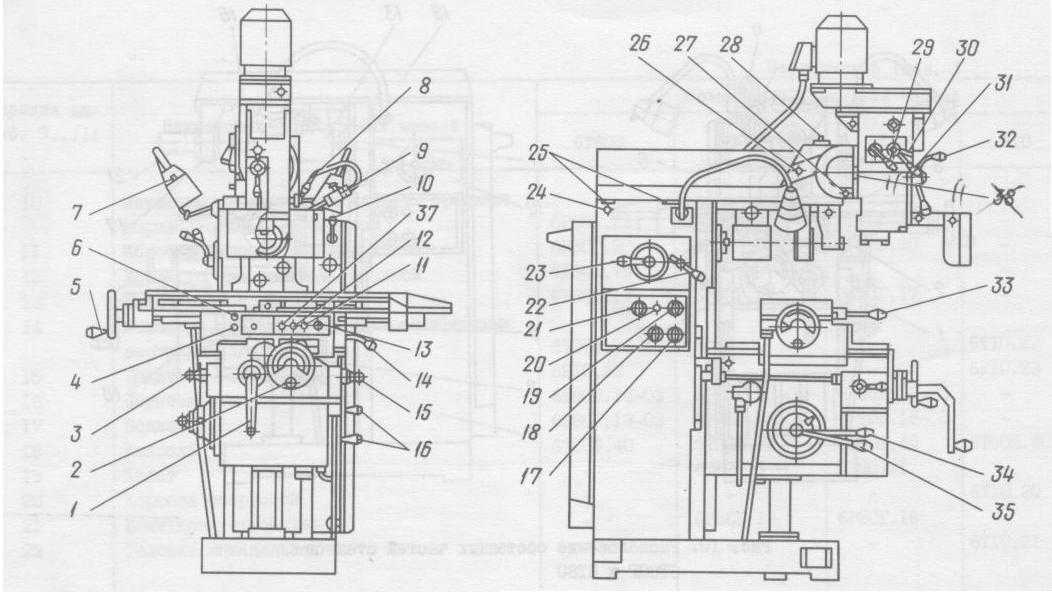

- вертикальный консольно-фрезерный станок ВМ127М

- вертикальный консольно-фрезерный станок 6Т13УП

- горизонтально-фрезерный станок 6М82Г

- горизонтально-фрезерный станок 6Р82Г

- горизонтально-фрезерный станок 6Р81

- токарно-винторезный станок CU-500M

- токарно-винторезный станок CU-730

- токарно-винторезный станок 16К25

- токарно-винторезный станок 16К20

- токарно-винторезный станок 1М63Ф101

- токарно-карусельный станок 1541

- продольно-строгальный станок 7231А

- поперечно-строгальный станок 7Б35

На нашем производстве используются также автоматизированные станки с ЧПУ для токарной обработки – токарный обрабатывающий центр с ЧПУ Samsung PL45LM и горизонтальный токарный станок с ЧПУ CJK61160.

Фрезерная обработка

Фрезерные станки предназначены для фрезерования всевозможных деталей из стали, чугуна и цветных металлов и сплавов торцевыми, концевыми, цилиндрическими, радиусными и другими фрезами. На таких станках можно обрабатывать горизонтальные, вертикальные и наклонные плоскости, пазы, углы, рамки, зубчатые колеса и т.д.

Вертикальный консольно-фрезерный станок ВМ127М

Технические характеристики станка ВМ127М

| Размеры рабочей поверхности стола, мм | 400×1600 | |

| Наибольшее перемещение стола, мм | продольное | 1000 |

| поперечное | 320 | |

| вертикальное | 420 | |

| Наибольшее перемещение пиноли шпинделя, мм | 80 | |

| Угол поворота шпиндельной головки, градусов | ±45 | |

Вертикальный консольно-фрезерный станок 6Т13УП

Технические характеристики станка 6Т13УП

| Класс точности по ГОСТ 8-82 | Н | |

| Размеры рабочей поверхности стола, мм | 400×1600 | |

| Наибольшее перемещение стола, мм | продольное | 1010 |

| поперечное | 400 | |

| вертикальное | 420 | |

Горизонтально-фрезерный станок 6Р82Г

Технические характеристики станка 6Р82Г

| Класс точности | Н | |

| Размеры рабочей поверхности стола, мм | 1250×320 | |

| Наибольшее перемещение стола, мм | продольное | 800 |

| поперечное | 250 | |

| вертикальное | 420 | |

Токарная обработка

Токарно-винторезные станки являются наиболее универсальными станками токарной группы и используются главным образом в условиях единичного и серийного производства. Позволяют выполнять все виды токарных и резьбонарезных работ.

Позволяют выполнять все виды токарных и резьбонарезных работ.

Токарно-винторезный станок CU-500M

Технические характеристики станка CU-500M

| Наибольший диаметр заготовки обрабатываемой над станиной, мм | 500 |

| Наибольший диаметр заготовки обрабатываемой над суппортом, мм | 300 |

| РМЦ, мм | 2000 |

Токарно-винторезный станок CU-730

Технические характеристики станка CU-730

| Наибольший диаметр заготовки обрабатываемой над станиной, мм | 730 |

| Наибольший диаметр заготовки обрабатываемой над суппортом, мм | 500 |

| РМЦ, мм | 3000 |

Токарно-винторезный станок 16К25

Технические характеристики станка 16К25

| Наибольший диаметр заготовки обрабатываемой над станиной, мм | 500 |

| Наибольший диаметр заготовки обрабатываемой над суппортом, мм | 290 |

| РМЦ, мм | 1000 |

Продольно-строгальная обработка

Обработка крупногабаритных заготовок с разноориентированными поверхностями выполняется продольно-строгальной операцией на продольно-строгальном станке. Эта операция особенно важна для заготовок с широкими плоскостями, с которых сложно снимать припуск фрезерованием. Заготовка прочно закрепляется на консольном столе станка, который совершает рабочее возвратно-поступательное движение. Строгальный резец установлен на суппорте, который совершает движение подачи. Снятие заданного припуска происходит при движении стола вперед. После обратного хода стола резец смещается на определенную величину для снятия нового припуска. Сила и глубина врезания резца в заготовку, скорость рабочего движения устанавливается в соответствии с техническим заданием.

Эта операция особенно важна для заготовок с широкими плоскостями, с которых сложно снимать припуск фрезерованием. Заготовка прочно закрепляется на консольном столе станка, который совершает рабочее возвратно-поступательное движение. Строгальный резец установлен на суппорте, который совершает движение подачи. Снятие заданного припуска происходит при движении стола вперед. После обратного хода стола резец смещается на определенную величину для снятия нового припуска. Сила и глубина врезания резца в заготовку, скорость рабочего движения устанавливается в соответствии с техническим заданием.

Продольно-строгальный станок 7231А

Технические характеристики станка 7231А

| Максимальная длина заготовки, мм | 3000 |

| Максимальная ширина заготовки, мм | 1000 |

| Максимальная высота заготовки, мм | 830 |

Преимущества работы с Механическим заводом «Спецмашмонтаж»

Важным преимуществом работы с нами является широкий спектр предоставляемых нашим заводом услуг по обработке металла. Наше предприятие имеет оборудование для резки, рубки, гибки листового и профильного проката, сварки, токарных, фрезерных, окрасочных и других операций. Фрезерная и токарная обработка может быть только частью технологических операций, необходимых заказчику. Обратившись к нам, Вы получите требуемый набор операций для производства конечных изделий.

Наше предприятие имеет оборудование для резки, рубки, гибки листового и профильного проката, сварки, токарных, фрезерных, окрасочных и других операций. Фрезерная и токарная обработка может быть только частью технологических операций, необходимых заказчику. Обратившись к нам, Вы получите требуемый набор операций для производства конечных изделий.

Механический завод «Спецмашмонтаж» предлагает полный комплекс услуг:

Проектирование металлоконструкций

Металлообработка

Изготовление металлоконструкций

Доставка

Монтаж металлоконструкций

Неразрушающий контроль

Любую интересующую Вас информацию по услугам фрезерной и токарной обработки можно получить у сотрудников нашей компании, связавшись с нами по телефону +7(495)583-78-86, по электронной почте Этот адрес электронной почты защищен от спам-ботов. У вас должен быть включен JavaScript для просмотра. или воспользовавшись формой обратной связи.

Если Вы хотите рассчитать стоимость услуги, пожалуйста, заполните форму обратной связи и приложите чертежи деталей. Наш менеджер свяжется с вами и предоставит предварительный расчет стоимости.

Наш менеджер свяжется с вами и предоставит предварительный расчет стоимости.

Технические характеристики виртуальной машины

Технические характеристики виртуальной машины

Red Hat Enterprise

Linux 6.2 (32-разрядная версия)Ред Хэт Энтерпрайз

Linux 6.4 (32-разрядная версия)Ред Хэт Энтерпрайз

Linux 6.7 (64-разрядная версия)CentOS Linux 7.3 (64-разрядная версия)

Ред Хэт Энтерпрайз

Linux 6.2 (32-разрядная версия)

Ниже приведены характеристики BDN 2.3.0.xxx.

Версия хоста xxx.ovf ( ххх = последний

номер сборки и версии).

| Операционная система и Минимальные технические характеристики оборудования для виртуальной машины | |

| Операционная система на виртуальной машине | Red Hat Enterprise Linux 6.2 32-битный |

| Минимальные требования к установке по умолчанию |

|

| Ethernet-адаптер 0 (статический IP-адрес) /etc/sysconfig/сетевые скрипты/ifcfg-eth0 | Устройство = eth0 BOOTPRTO = нет ТИП = Ethernet HWADDR = 00:0c:29:09:a9:f2 ЗАГРУЗКА = Да Сетевая маска = 255.255.255.0 IPV6INIT = Нет |

| Ethernet-адаптер 1 (DHCP) /etc/sysconfig/сетевые скрипты/ifcfg-eth2 | Устройство = eth2 BOOTPRTO = DHCP ТИП = Ethernet HWADDR = 00:0c:29:09:a9:fc ПЕРДНС = да |

| Процессы и полезные команды | ||

| Процесс | Каталог | Описание |

| монитор | /etc/init.d/monit | monit — утилита для управления ./монит стоп ./монитор старт ./мониторинг перезагрузки Должен быть root или суперпользователь для выполнения |

| веб-сайт | /etc/init.d/webuid | Полезные команды ./веб-стоп ./webuid начало ./webuid перезапустить Должен быть root или суперпользователь для выполнения |

Установленные пакеты

Установленные пакеты Red Hat Enterprise

Linux 6.2 (PDF)

Ред Хэт Энтерпрайз

Linux 6.4 (32-разрядная версия)

Ниже приведены характеристики BDN 2.3.0.xxx.

Версия хоста xxx.ovf ( xxx = последняя

номер сборки и версии).

| Операционная система и Минимальные технические характеристики оборудования для виртуальной машины | |

| Операционная система на виртуальной машине | Red Hat Enterprise Linux 6. 4 432-битный |

| Минимальные требования к установке по умолчанию |

|

| Ethernet-адаптер 0 (статический IP-адрес) /etc/sysconfig/сетевые скрипты/ifcfg-eth0 | УСТРОЙСТВО=eth0 ТИП=Ethernet НА ЗАГРУЗКЕ=да NM_CONTROLLED=да BOOTPROTO=нет IP-АДРЕС=192.168.1.100 ПРЕФИКС=24 DEFROUTE=да IPV4_FAILURE_FATAL=да IPV6INIT=нет ИМЯ=»Система |

| Ethernet-адаптер 1 (DHCP) /etc/sysconfig/network-scripts/ifcfg-eth2 | УСТРОЙСТВО=eth2 ТИП=Ethernet НА ЗАГРУЗКЕ=нет NM_CONTROLLED=да ЗАГРУЗКА_ПРОТО=DHCP HWADDR=00:0C:29:07:62:3A DEFROUTE=да PEERDNS=да РАСШИРЕННЫЕ МАРШРУТЫ=да IPV4_FAILURE_FATAL=да IPV6INIT=нет ИМЯ=»Система |

| Процессы и полезные команды | ||

| Процесс | Каталог | Описание |

| монитор | /etc/init. d/monit d/monit | monit — утилита для управления ./монит стоп ./монитор старт ./мониторинг перезагрузки Должен быть root или суперпользователь для выполнения |

| веб-сайт | /etc/init.d/webuid | Полезные команды ./веб-стоп ./webuid начало ./webuid перезапустить Должен быть root или суперпользователь для выполнения |

Установленные пакеты

Установленные пакеты Red Hat Enterprise

Linux 6.4 (PDF)

Ред Хэт Энтерпрайз

Linux 6.7 (64-разрядная версия)

Ниже приведены характеристики BDN 2.3.0.xxx.

Версия хоста xxx.ovf ( xxx = последняя

номер сборки и версии).

| Операционная система и Минимальные технические характеристики оборудования для виртуальной машины | |

| Операционная система на виртуальной машине | Red Hat Enterprise Linux 6.7 64-битный |

| Минимальные требования к установке по умолчанию |

|

| Ethernet-адаптер 0 (статический IP-адрес) /etc/sysconfig/сетевые скрипты/ifcfg-eth0 | УСТРОЙСТВО=eth0 ТИП=Ethernet НА ЗАГРУЗКЕ=да NM_CONTROLLED=да BOOTPROTO=нет IP-АДРЕС=192. ПРЕФИКС=24 DEFROUTE=да IPV4_FAILURE_FATAL=да IPV6INIT=нет ИМЯ=»Система |

| Ethernet-адаптер 1 (DHCP) /etc/sysconfig/network-scripts/ifcfg-eth2 | УСТРОЙСТВО=eth2 ТИП=Ethernet НА ЗАГРУЗКЕ=нет NM_CONTROLLED=да ЗАГРУЗКА_ПРОТО=DHCP HWADDR=00:0C:29:5A:24:35 DEFROUTE=да PEERDNS=да РАСШИРЕННЫЕ МАРШРУТЫ=да IPV4_FAILURE_FATAL=да IPV6INIT=нет ИМЯ=»Система |

| Процессы и полезные команды | ||

| Процесс | Каталог | Описание |

| монитор | /etc/init.d/monit | monit — утилита для управления ./монит стоп ./монитор старт ./мониторинг перезагрузки Должен быть root или суперпользователь для выполнения |

| веб-сайт | /etc/init.d/webuid | Полезные команды ./веб-стоп ./webuid начало ./webuid перезапустить Должен быть root или суперпользователь для выполнения |

Установленные пакеты

Установленные пакеты Red Hat Enterprise

Linux 6. 7 (PDF)

7 (PDF)

CentOS Linux 7.3 (64-разрядная версия)

Ниже приведены характеристики BDN 2.3.0.xxx.

Версия хоста xxx.ovf ( xxx = последняя

номер сборки и версии).

| Операционная система и Минимальные технические характеристики оборудования для виртуальной машины | |

| Операционная система на виртуальной машине | CentOS Linux 7.3 (1611), 64-разрядная версия |

| Минимальные требования к установке по умолчанию |

|

| Ethernet-адаптер 0 (DHCP) /etc/sysconfig/сетевые скрипты/ifcfg-eth0 | ТИП=Ethernet ЗАГРУЗКА_ПРОТО=DHCP DEFROUTE=да IPV4_FAILURE_FATAL=нет IPV6INIT=да IPV6_AUTOCONF=да IPV6_DEFROUTE=да IPV6_FAILURE_FATAL=нет IPV6_ADDR_GEN_MODE=стабильная конфиденциальность ИМЯ=eth0 УСТРОЙСТВО=eth0 НА ЗАГРУЗКЕ=да PEERDNS=да РАСШИРЕННЫЕ МАРШРУТЫ=да IPV6_PEERDNS=да IPV6_PEERROUTES=да |

| Процессы и полезные команды | ||

| Процесс | Каталог | Описание |

| монитор | /etc/init. d/monit d/monit | monit — утилита для управления сервис запуск службы мониторинга перезапуск сервисного монитора Должен быть root или суперпользователь для выполнения |

| веб-сайт | /etc/init.d/webuid | Полезные команды ./веб-стоп ./webuid начало . Должен быть root или суперпользователь для выполнения |

Установленные пакеты

Установленные пакеты для CentOS

7.3 (PDF)

MICHELIN X® MULTI™ Z/D (17,5

МИШЛЕН

X ® MULTI™ Z/D (17,5–19,5)

- Универсальность

- Всесезонная мобильность

MICHELIN X MULTI Z/D (17,5–19,5)

- Универсальность

- Всесезонная мобильность

Безопасность, мобильность и устойчивость на дороге для вашего легкого грузовика

- Потенциал пробега и надежность

- Надежное обращение

- Мобильность в любое время года

Возможность восстановления (Подробнее)

восстанавливаемый

Ассортимент шин MICHELIN X® MULTI™ адаптирован для крупногабаритных грузовых автомобилей до 19 тонн (жесткие/легкие грузовики) для ваших городских перевозок и доставки посылок .

Шины доступны для жестких дисков 4×2 или 6×2, а также для небольших автобусов с дисками 17,5 или 19,5 дюймов.

Предлагается шириной от 205 до 285, в частности, 215/75 R17,5, 265/70 R19,5 и 285/70 R19,5.

Ассортимент шин MICHELIN X® MULTI™ адаптирован для крупногабаритных грузовых автомобилей до 19 тонн (жесткие/легкие грузовики) для ваших городских перевозок и доставки посылок .

Шины доступны для жестких дисков 4×2 или 6×2, а также для небольших автобусов с дисками 17,5 или 19,5 дюймов.

Предлагается шириной от 205 до 285, в частности, 215/75 R17,5, 265/70 R19,5 и 285/70 R19,5.

ПОЧЕМУ ВЫБРАТЬ ЭТУ ШИНУ?

пикто евро экономия скорректирована

ВЫПОЛНЯЙТЕ СРОКИ СНИЖАЙТЕ ВАШИ РАСХОДЫ

Вы сократите время простоя вашего автомобиля , так как вы оптимизируете свои расходы, проезжая дольше (1) с теми же шинами: их срок службы до 2 на 6 месяцев дольше (2), чем у их предшественника MICHELIN XDE 2.

Logo picto Safety small Tire

ЕЗДИТЕ СО СПОКОЙСТВИЕМ В ПОЛНОЙ БЕЗОПАСНОСТИ

Если вам нужно объехать препятствие в последнюю минуту или срочно затормозить во время дождя, линейка MICHELIN X® MULTI™ в размерах 17,5 и 19.5 прошел тщательные испытания. Доказательство можно увидеть в наших видео ниже.

Логотип всесезонная малая шина

ВЕДИТЕ СВОЙ БИЗНЕС КРУГЛЫЙ ГОД

Максимально используйте свое время и снизьте расходы, сохраняя свои шины независимо от погодных условий. Вся линейка шин MICHELIN X® MULTI™ размером 17,5 и 19,5 мм имеет маркировку 3PMSF , обеспечивающую оптимальное сцепление в условиях снега.

MICHELIN — Gamme Petit Poids Lourd — Prêt à afffronter toutes les climatiques — FR/EN

Ваша мобильность сохраняется даже в снегу

Вы работаете 365/7, и ваши клиенты ожидают получить свою доставку независимо от погодных условий. Шины MICHELIN X® MULTI™ — это настоящие всесезонные шины (маркировка 3PMSF), чтобы оставаться активными круглый год.

Шины MICHELIN X® MULTI™ — это настоящие всесезонные шины (маркировка 3PMSF), чтобы оставаться активными круглый год.

MICHELIN — Gamme Petit Poids Lourd — Претендент на вызов городским джунглям — FR/EN

Маневренность без компромиссов для вашей безопасности

Никогда не знаешь, что встретится перед твоим грузовиком, особенно в городских районах: шины MICHELIN X® MULTI™ 17,5–19,5 помогут вам подготовиться к любым ситуациям. Вы сохраните контроль для большей безопасности.

MICHELIN — Gamme Petit Poids Lourd — Prêt à freiner court en toutescies — FR/EN

Безопасность при торможении даже при ношении

Вы знаете, что в городе или других городских районах счетчик может иметь значение. Хотя новая шина безопасна, что делать, если она изношена? Узнайте, как линейка MICHELIN X® MULTI ™ позволяет вам оставаться в безопасности: испытание на торможение на мокрой дороге с шинами, на 2/3 изношенными, под бдительным надзором независимой организации TÜV.

Безрезультатно

Ваш поиск

Все размеры (20)

Многопозиционный

- 9.5R17.5 TL 129/127L ВМ МИ

- 205/75R17.5 ТЛ 124/122М ВГ МИ

- 205/75R17.5 ТЛ 124/122М ВК МИ

- 205/75R17.5 ТЛ 124/122М ВК МИ

- 215/75R17.

5 ТЛ 126/124М ВМ МИ

5 ТЛ 126/124М ВМ МИ - 225/75R17.5 ТЛ 129/127М ВГ МИ

- 235/75R17.5 ТЛ 132/130М ВГ МИ

- 245/70R17.5 ТЛ 136/134М ВМ МИ

- 265/70R17.5 ТЛ 140/138М ВГ МИ

- 245/70R19.5 ТЛ 136/134М ВГ МИ

- 5 ТЛ 140/138М ВГ МИ

- 285/70R19.5 TL 146/144L VM МИ

Положение привода

- 205/75R17.5 ТЛ 124/122М ВГ МИ

- 215/75R17.5 ТЛ 126/124М ВГ МИ

- 225/75R17.5 ТЛ 129/127М ВГ МИ

- 235/75R17.5 ТЛ 132/130М ВГ МИ

- 245/70R17.

5 ТЛ 136/134М ВГ МИ

5 ТЛ 136/134М ВГ МИ - 265/70R19.5 ТЛ 140/138М ВГ МИ

- 285/70R19.5 ТЛ 146/144Л ВГ МИ

Технические характеристики

Товар | MICHELIN X MULTI Z 17,5″-19,5″ — 9,5R17,5 |

|---|---|

Должность | Все позиции |

М+С | нет |

3PMSF | нет |

RFID | да |

Индекс нагрузки | 129 |

Индекс скорости | л |

ЦАИ | 425633 |

Эта шина также может вас заинтересовать

Правовая информация

(1) Рыночные испытания среди пользователей, 2011/2012 гг. — Результаты показали увеличение срока службы на 18 % по сравнению с шиной MICHELIN XDE 2.

— Результаты показали увеличение срока службы на 18 % по сравнению с шиной MICHELIN XDE 2.

(2) Гипотеза: если шина MICHELIN XDE 2 прослужит 12 месяцев, то шина MICHELIN X® MULTI™ D прослужит 14 месяцев, или на 18 % больше.

Michelin X® MULTI™ Z / D (17,5–19,5) Грузовая шина

МИШЛЕН

Х ® MULTI™ Z/D (17,5–19,5)

- Универсальность

- Всесезонная мобильность

MICHELIN X MULTI Z/D (17,5–19,5)

- Универсальность

- Всесезонная мобильность

Безопасность, мобильность и устойчивость на дороге для вашего легкого грузовика

- Потенциал пробега и надежность

- Надежное обращение

- Мобильность в любое время года

Возможность восстановления (Подробнее)

Восстанавливаемый (Подробнее)

Ассортимент шин MICHELIN X® MULTI™ адаптирован для крупногабаритных грузовых автомобилей до 19 тонн (жесткие/легкие грузовики) для ваших городских перевозок и доставки посылок .

Шины доступны для жестких дисков 4×2 или 6×2, а также для небольших автобусов с дисками 17,5 или 19,5 дюймов.

Предлагается шириной от 205 до 285, в частности, 215/75 R17,5, 265/70 R19,5 и 285/70 R19,5.

Ассортимент шин MICHELIN X® MULTI™ адаптирован для крупногабаритных грузовых автомобилей до 19 тонн (грузовики с жесткой рамой/легкие грузовики) для вашей городской службы доставки и доставки посылок .

Шины доступны для жестких дисков 4×2 или 6×2, а также для небольших автобусов размером 17,5 или 19.5-дюймовые диски.

Предлагается шириной от 205 до 285, в частности, 215/75 R17,5, 265/70 R19,5 и 285/70 R19,5.

ПОЧЕМУ ВЫБРАТЬ ЭТУ ШИНУ?

Logo picto saves small Tire

ВЫПОЛНЯЙТЕ СРОКИ

СНИЖАЙТЕ ВАШИ РАСХОДЫ

Вы сократите время простоя вашего автомобиля , так как вы оптимизируете свои расходы, проезжая дольше (1) с теми же шинами: их срок службы истек на 2–6 месяцев дольше (2), чем у их предшественника MICHELIN XDE 2.

ES Logo picto безопасность малая шина

ЕЗДИТЕ СО СПОКОЙСТВИЕМ

В ПОЛНОЙ БЕЗОПАСНОСТИ

Если вам нужно объехать препятствие в последнюю минуту или срочно затормозить во время дождя, линейка MICHELIN X® MULTI™ в размерах 17,5 и 19,5 прошла тщательные испытания. Доказательство можно увидеть в наших видео ниже.

Логотип всесезонная малая шина

ВЕДИТЕ СВОЙ БИЗНЕС

КРУГЛЫЙ ГОД

Максимально используйте свое время и снизьте расходы, сохраняя свои шины независимо от погодных условий. Весь ассортимент MICHELIN X® MULTI™ в размерах 17,5 и 19.5 имеет маркировку 3PMSF , обеспечивающую оптимальное сцепление в условиях снега.

Конфиденциальность файлов cookie

Чтобы посмотреть это видео, вам необходимо принять некоторые файлы cookie с платформы Youtube. Просто нажмите на кнопку ниже, чтобы открыть модуль cookie.

Принять куки ютуба

MICHELIN — Gamme Petit Poids Lourd — Prêt à afffronter toutes les climatiques — FR/EN

Ваша мобильность сохраняется даже в снегу

Вы работаете 365/7, и ваши клиенты ожидают получить свою доставку независимо от погодных условий. Шины MICHELIN X® MULTI™ — это настоящие всесезонные шины (маркировка 3PMSF), чтобы оставаться активными круглый год.

Конфиденциальность файлов cookie

Чтобы посмотреть это видео, вам необходимо принять некоторые файлы cookie с платформы Youtube. Просто нажмите на кнопку ниже, чтобы открыть модуль cookie.

Принять куки ютуба

MICHELIN — Gamme Petit Poids Lourd — Prêt à afffronter la Jungle urbaine — FR/EN

Маневренность без компромиссов для вашей безопасности

Особенно в городских районах, вы никогда не знаете, что может произойти перед вашим грузовиком: шины MICHELIN X® MULTI™ 17,5–19,5 помогут вам подготовиться к любым ситуациям. Вы сохраните контроль для большей безопасности.

Вы сохраните контроль для большей безопасности.

Конфиденциальность файлов cookie

Чтобы посмотреть это видео, вам необходимо принять некоторые файлы cookie с платформы Youtube. Просто нажмите на кнопку ниже, чтобы открыть модуль cookie.

Принять куки ютуба

MICHELIN — Gamme Petit Poids Lourd — Prêt à freiner court en toutescies — FR/EN

Безопасность при торможении даже при ношении

Вы знаете, что в городе или других городских районах счетчик может иметь значение. Хотя новая шина безопасна, что делать, если она изношена? Узнайте, как линейка MICHELIN X® MULTI ™ позволяет вам оставаться в безопасности: испытание на торможение на мокрой дороге с шинами, на 2/3 изношенными, под бдительным надзором независимой организации TÜV.

Безрезультатно

Ваш поиск

Все размеры (18)

Многопозиционный

- 205/75R17.

5 ТЛ 124/122М ВГ МИ

5 ТЛ 124/122М ВГ МИ - 215/75R17.5 ТЛ 126/124М ВМ МИ

- 225/75R17.5 ТЛ 129/127М ВГ МИ

- 235/75R17.5 ТЛ 132/130М ВГ МИ

- 245/70R17.5 ТЛ 136/134М ВМ МИ

- 265/70R17.5 ТЛ 140/138М ВГ МИ

- 245/70R19.

5 ТЛ 136/134М ВГ МИ

5 ТЛ 136/134М ВГ МИ - 285/70R19.5 TL 146/144L VM МИ

Положение привода

- 205/75R17.5 ТЛ 124/122М ВГ МИ

- 215/75R17.5 ТЛ 126/124М ВГ МИ

- 225/75R17.5 ТЛ 129/127М ВГ МИ

- 235/75R17.

5 ТЛ 132/130М ВГ МИ

5 ТЛ 132/130М ВГ МИ - 245/70R17.5 ТЛ 136/134М ВГ МИ

- 265/70R17.5 ТЛ 140/138М ВГ МИ

- 265/70R19.5 ТЛ 140/138М ВГ МИ

- 285/70R19.5 ТЛ 146/144Л ВГ МИ

Маркировка

Этикетка

- КЛАСС ТОПЛИВНОЙ ЭФФЕКТИВНОСТИ

Д

- КЛАСС ВЛАЖНОГО СЦЕПЛЕНИЯ

Б

- ВНЕШНИЙ КЛАСС ШУМА ПРИ КАЧЕНИИ

70 дБ

Технические характеристики

Товар | MICHELIN X MULTI Z 17,5″-19,5″ — 205/75R17,5 |

|---|---|

Должность | Z — Многопозиционный |

М+С | Да |

3PMSF | Да |

RFID | Да |

Общий диаметр | 755 мм |

Общая ширина | 210 мм |

Рекомендуемые диски | 6. |

Одобренные диски | 6,00×17,5 |

Минимальный двойной интервал | 238 мм |

Максимальная скорость (км/ч) | 130 |

Максимальная нагрузка на одну шину | 3200 кг |

Максимальная нагрузка на шину двойная | 6000 кг |

Индекс нагрузки | 124 |

Индекс скорости | М |

ЦАИ | 812426 |

Информация о нарезке

| Теоретическая глубина нарезки | 2 |

|---|---|

| Ширина нарезки | 7 — 8 |

| Лезвие | R3 |

| Шаблон повторной канавки |

Эта шина также может вас заинтересовать

Правовая информация

(1) Рыночные испытания среди пользователей, 2011/2012 гг. — Результаты показали увеличение срока службы на 18 % по сравнению с шиной MICHELIN XDE 2.

— Результаты показали увеличение срока службы на 18 % по сравнению с шиной MICHELIN XDE 2.

(2) Гипотеза: если шина MICHELIN XDE 2 прослужит 12 месяцев, то шина MICHELIN X® MULTI™ D прослужит 14 месяцев, или на 18 % больше.

63-узловой кластер EKS, работающий на одном экземпляре с Firecracker

Этот пост является частью серии постов, посвященных автоматизации Firecracker . В настоящее время он состоит из

следующие сообщения:

- Часть I:

Автоматизация запуска виртуальных машин на основе ванильных облачных образов на Firecracker - Часть II (текущая)

.

Разрабатывая исходный код, созданный для автоматизации создания виртуальных машин Firecracker, этот пост покажет, как мы можем

создать кластер, совместимый с EKS (как в Amazon EKS), с несколькими узлами, где каждый

узел будет виртуальной машиной, работающей на одном хосте, благодаря Firecracker .

Весь исходный код доступен в

этот репозиторий GitLab.

Создание кластера EKS из виртуальных машин Firecracker

EKS? Разве это не управляемый AWS сервис Kubernetes? Это, конечно, так, но это также недавно объявленный открытый исходный код и

предоставлен Amazon Web Services. Последний

более точно называется EKS Distro (EKS-D), а его исходный код доступен на

этот репозиторий Github.

В частности, будет использоваться совместимый с EKS-D дистрибутив Ubuntu на основе оснастки, поскольку он

довольно прост в установке и эксплуатации на виртуальных машинах Ubuntu. Интересно, что это распределение основано на

microk8s, и помечен как « EKS-совместимый Kubernetes ». « Совместимость » в этом контексте

похоже, что это своего рода microk8s, «одетый как» EKS, поскольку он включает в себя бинарный файл eks , который работает, как и ожидалось.

в другом месте. Но поскольку он основан на microk8s, то, наверное, подходит только для тех случаев, когда есть microk8s.

С помощью кода, разработанного в рамках предыдущего поста, можно создать настраиваемое количество виртуальных машин Firecracker.

автоматически, с SSH без пароля, настроенным с пользователем fc , который также может без пароля sudo . Учитывая это и

что нам нужно установить и настроить экземпляры для установки EKS-D Ubuntu, Ansible был

идеальный кандидат для этой автоматизации.

Весь код Ansible можно найти в

доступный /

папка. Я не являюсь экспертом по Ansible, поэтому код подлежит множеству улучшений (не стесняйтесь присылать MR!). Код должен быть

совершенно не требует пояснений — за исключением части инвентаря, которая потребовала некоторых дополнительных сценариев оболочки, которые можно найти

в

05-install_eks_via_ansible.sh

файл.

Есть две проблемы, которые нам нужно решить с помощью сценария оболочки:

Создать динамическую инвентаризацию. По сути, количество виртуальных машин основано на переменной

NUMBER_VMS, определенной в

переменныхфайла. Первый узел будет считаться ведущим EKS, а все остальные узлы рабочими.После установки оснастки

екскаждый узел будет отдельным «мастером». Для формирования единого кластера нам нужно запустить 9Команда 1152 eks add-node в мастере для каждого узла и эквивалентная команда

Для формирования единого кластера нам нужно запустить 9Команда 1152 eks add-node в мастере для каждого узла и эквивалентная команда eks joinв узлах. Обе команды используют токен,

который может быть сгенерирован автоматически (не удобно для этого варианта использования) или предоставлен. Сценарий оболочки генерирует эти токены

и предоставить их как переменные: токен для каждого узла и список всех токенов для главного узла.

Вы можете запустить этот код в своей среде. Обзор

README.md

файл и убедитесь, что firecracker установлен и правильно настроен, как описано в

первый пост. 4 ГБ и 2

ядер кажется разумным минимумом ресурсов, необходимых для каждой виртуальной машины для запуска успешного кластера, совместимого с EKS-D. Регулировать

переменных файла в вашу среду.

Создание кластера EKS с 63 узлами на экземпляре r5d.metal

Было бы здорово создать большой кластер EKS, работающий на множестве виртуальных машин… и все это на одном «большом» хосте? Это

эксперимент я провожу. Я выбрал экземпляр

Я выбрал экземпляр r5d.metal (96 ядер, 768 ГБ ОЗУ,

Локальный твердотельный накопитель NVMe емкостью 3,6 ТБ) как лучшее сочетание большого количества ядер, оперативной памяти и локального хранилища (поскольку мы будем создавать

«тома» для виртуальных машин, и это должно быть максимально быстро). Затем запустил 100 виртуальных машин Firecracker и создал EKS.

кластер…

Я установил

количество вилок Ansible

до 32, чтобы иметь больше параллелизма. Однако похоже даже при низком параллелизме есть ошибки с экс джоин

операция вызвана ограничениями на максимальное количество запросов к kubeapi-серверу, поэтому

эта часть кода Ansible сериализуется.

Виртуальные машины с 2 ядрами и 4 ГБ ОЗУ. Код сработал. Скрипты, ансибл, все заработало. Чуть позже, через 4 часа,

Кластер EKS из 100 узлов, созданный в одном экземпляре, работал:

Однако нагрузка превышала 200 , и хотя использование памяти было приемлемым (2/3 оперативной памяти системы), кластер был

непригодный для использования. Но что более важно, я обнаружил интересный факт:

Но что более важно, я обнаружил интересный факт: узла kubectl get вернули бы только 63 узла, несмотря на

99 операций соединения узлов были возвращены как успешные. Я особо не копал, но тут видимо есть ограничение

(внутреннее ограничение microk8s? В любом случае не уверен, что microk8s был тщательно протестирован с таким большим количеством кластеров

экземпляры…).

Поэтому я решил повторить операцию, но с «всего» 63 ВМ (ведь kubectl get узлов больше не вернут…) и

увеличьте характеристики ВМ до 4-ядерных (виртуальная машина главного узла также была загружена более чем на 100%) и 16 ГБ ОЗУ (16 ГБ * 63 — это

больше, чем доступная оперативная память системы, но Firecracker допускает чрезмерную нагрузку как на память, так и на ЦП, если не все

процессы используют всю выделенную оперативную память). Это сработало лучше, кластер был успешно создан и kubectl получили узлы .

сообщил на этот раз все узлы. Все примерно за 3 часа, сейчас при приемлемой загрузке процессора:

ubuntu@ip-172-31-93-220:~$ kubectl получить узлы ИМЯ СТАТУС РОЛИ ВОЗРАСТ ВЕРСИЯ id13090 Готов <нет> 116м v1.

18.9-екс-1-18-1 id08

735 Готов <нет> 93м v1.18.9-екс-1-18-1 id1865400204 Готов <нет> 85м v1.18.9-екс-1-18-1 id3176525421 Готов <нет> 79м v1.18.9-екс-1-18-1 id0289819564 Готов <нет> 97м v1.18.9-екс-1-18-1 id2364814864 Готов <нет> 101м v1.18.9-экс-1-18-1 id1576708969 Готов <нет> 62м v1.18.9-екс-1-18-1 id083

1 Готов <нет> 94м v1.18.9-екс-1-18-1 id13544 Готов <нет> 83м v1.18.9-екс-1-18-1 id25090 Готов <нет> 95м v1.18.9-eks-1-18-1 id23855 Готов <нет> 122м v1.18.9-екс-1-18-1 id2162009048 Готов <нет> 99м v1.18.9-екс-1-18-1 id003241 Готов <нет> 72м v1.18.9-екс-1-18-1 id13

381 Готов <нет> 56м v1.18.9-экс-1-18-1 id3180021860 Готов <нет> 132м v1.18.9-екс-1-18-1 id2766207659 Готов <нет> 130м v1.18.9-eks-1-18-1 id2417208994 Готов <нет> 67м v1.18.9-екс-1-18-1 id0037315342 Готов <нет> 126м v1.18.9-екс-1-18-1 id2870

2 Готов <нет> 124м v1.18.9-екс-1-18-1 id0303528979 Готов <нет> 96м v1.18.9-екс-1-18-1 id2443620467 Готов <нет> 100м v1.18.9-eks-1-18-1 id2671116621 Готов <нет> 89м v1.18.9-экс-1-18-1 id1153

1 Готов <нет> 127м v1.18.9-екс-1-18-1 id1618117867 Готов <нет> 114м v1.18.9-екс-1-18-1 id1345427105 Готов <нет> 128м v1.18.9-екс-1-18-1 id1578112374 Готов <нет> 133м v1.18.9-екс-1-18-1 id2260431270 Готов <нет> 134м v1.18.9-екс-1-18-1 id11052 Готов <нет> 131м v1.18.9-екс-1-18-1 id00056 Готов <нет> 86м v1.18.9-екс-1-18-1 id0772428726 Готов <нет> 112м v1.18.9-экс-1-18-1 id2345631371 Готов <нет> 115м v1.18.9-екс-1-18-1 id0866401320 Готов <нет> 90м v1.18.9-eks-1-18-1 id22569 Готов <нет> 121м v1.18.9-екс-1-18-1 id31 619 Готов <нет> 105м v1.18.9-екс-1-18-1

id3212514411 Готов <нет> 64м v1.18.9-екс-1-18-1

id2530228284 Готов <нет> 58м v1.18.9-екс-1-18-1

id1582731567 Готов <нет> 125м v1.18.9-екс-1-18-1

id0234531685 Готово <нет> 104 м v1.18.9-экс-1-18-1

id1170407709 Готов <нет> 129м v1.18.9-екс-1-18-1

id2377401525 Готов <нет> 129м v1.18.9-екс-1-18-1

id27829 Готов <нет> 109м v1.18.9-екс-1-18-1

id2316206444 Готов <нет> 88м v1.18.9-екс-1-18-1

id0886017938 Готов <нет> 120м v1.18.9-eks-1-18-1

id2886224137 Готов <нет> 135м v1.18.9-екс-1-18-1

id2137806005 Готов <нет> 74м v1.18.9-екс-1-18-1

id3252717927 Готов <нет> 136м v1.18.9-экс-1-18-1

id1421103858 Готов <нет> 111м v1.18.9-екс-1-18-1

id2048704797 Готов <нет> 102м v1.18.9-екс-1-18-1

id18011 Готов <нет> 106м v1.18.9-екс-1-18-1

id07146 Готов <нет> 61м v1.18.9-екс-1-18-1

id1134505657 Готов <нет> 82м v1.18.9-екс-1-18-1

id0023523299 Готов <нет> 118м v1.18.9-екс-1-18-1

id2477116066 Готов <нет> 81м v1.18.9-екс-1-18-1

id04618 Готов <нет> 77м v1.18.9-экс-1-18-1

id1020429150 Готов <нет> 113м v1.18.9-екс-1-18-1

id1471722684 Готов <нет> 91м v1.18.9-екс-1-18-1

id1417322458 Готов <нет> 75м v1.18.9-eks-1-18-1

id0107720352 Готов <нет> 69м v1.18.9-екс-1-18-1

id29576 Готов <нет> 108м v1.18.9-екс-1-18-1

id0573606644 Готов <нет> 3ч54м v1.18.9-экс-1-18-1

id1377114631 Готов <нет> 117м v1.18.9-екс-1-18-1

id0468822693 Готов <нет> 119м v1.18.9-экс-1-18-1

id0660532190 Готов <нет> 71м v1.18.9-екс-1-18-1Несмотря на все это, кластер нельзя было использовать.

Большинство операций выполнялись долго, а некоторые приводили к ошибкам.

Вероятно, микрок8, на котором основан этот ЭКС-Д, не предназначен для этих целей 😉Заключительные слова

Эксперимент с 63 и 100 узлами был скорее забавным упражнением и проверкой скриптов и кода Ansible. Однако,

код представлен

весьма полезен, особенно для тестирования сценариев. Я могу создать на своем ноутбуке 3-узловой кластер EKS (2 ядра, 4 ГБ ОЗУ на

узел) менее чем за 5 минут, и все это с помощью однострочной команды. И уничтожь все это за секунды еще одной строчкой . Этот

позволяет быстро тестировать EKS-совместимые кластеры Kubernetes. Все благодаря Firecracker и EKS-D, оба с открытым исходным кодом

компоненты, выпущенные AWS. Спасибо!Задачи узла | Конфигурация после установки

- Добавление вычислительных машин RHEL в кластер OpenShift Container Platform

- О добавлении вычислительных узлов RHEL в кластер

- Системные требования для вычислительных узлов RHEL

- Подготовка машины к запуску playbook

- Подготовка вычислительного узла RHEL

- Добавление вычислительной машины RHEL в ваш кластер

- Обязательные параметры для файла хостов Ansible

- Необязательно: удаление вычислительных машин RHCOS из кластера

- Добавление вычислительных машин RHCOS в кластер OpenShift Container Platform

- Предпосылки

- Создание дополнительных машин RHCOS с использованием образа ISO

- Создание дополнительных машин RHCOS с помощью загрузки PXE или iPXE

- Утверждение запросов на подпись сертификатов для ваших машин

- Добавление нового рабочего узла RHCOS с пользовательским разделом

/varв AWS- Развертывание проверки работоспособности компьютера

- О проверках работоспособности машины

- Образец ресурса MachineHealthCheck

- Создание ресурса MachineHealthCheck

- Масштабирование машинного набора вручную

- Понимание разницы между наборами машин и пулом конфигурации машин

- Рекомендуемые методы размещения узла

- Создание CRD KubeletConfig для редактирования параметров kubelet

- Изменение количества недоступных рабочих узлов

- Размер узла плоскости управления

- Настройка диспетчера ЦП

- Огромные страницы

- Что делают огромные страницы

- Как огромные страницы потребляются приложениями

- Настройка огромных страниц

- Общие сведения о подключаемых модулях устройств

- Методы развертывания подключаемого модуля устройства

- Общие сведения о диспетчере устройств

- Включение диспетчера устройств

- Пороки и допуски

- Понимание недостатков и допусков

- Добавление недостатков и допусков

- Добавление примесей и допусков с помощью машинного набора

- Привязка пользователя к узлу с использованием taints и допусков

- Управление узлами с помощью специального оборудования с использованием исправлений и допусков

- Удаление пороков и допусков

- Менеджер топологии

- Политики менеджера топологии

- Настройка менеджера топологии

- Взаимодействие модулей с политиками Topology Manager

- Запросы ресурсов и чрезмерное выделение ресурсов

- избыточная фиксация на уровне кластера с использованием оператора переопределения ресурсов кластера

- Установка оператора переопределения ресурсов кластера с помощью веб-консоли

- Установка оператора переопределения ресурсов кластера с помощью интерфейса командной строки

- Настройка избыточной фиксации на уровне кластера

- избыточная фиксация на уровне узла

- Общие сведения о вычислительных ресурсах и контейнерах

- Понимание чрезмерной ответственности и качества обслуживания классов

- Общие сведения о памяти подкачки и QOS

- Понимание чрезмерной фиксации узлов

- Отключение или применение ограничений ЦП с помощью квот ЦП CFS

- Резервирование ресурсов для системных процессов

- Отключение чрезмерной фиксации для узла

- Ограничения на уровне проекта

- Отключение чрезмерной фиксации для проекта

- Освобождение ресурсов узла с помощью сборки мусора

- Понимание того, как завершенные контейнеры удаляются с помощью сборки мусора

- Понимание того, как изображения удаляются при сборке мусора

- Настройка сборки мусора для контейнеров и образов

- Использование оператора настройки узла

- Доступ к примеру спецификации оператора настройки узла

- Спецификация пользовательской настройки

- Профили по умолчанию, установленные на кластере

- Поддерживаемые подключаемые модули демона TuneD

- Настройка максимального количества модулей на узел

После установки OpenShift Container Platform вы можете дополнительно расширить и настроить свой

кластер в соответствии с вашими требованиями с помощью определенных задач узла.Добавление вычислительных машин RHEL в кластер OpenShift Container Platform

Понимание и работа с вычислительными узлами RHEL.

О добавлении вычислительных узлов RHEL в кластер

В OpenShift Container Platform 4.10 у вас есть возможность использовать машины Red Hat Enterprise Linux (RHEL) в качестве вычислительных машин в вашем кластере, если вы используете установку инфраструктуры, предоставленную пользователем на

x86_64архитектура. Вы должны использовать компьютеры Red Hat Enterprise Linux CoreOS (RHCOS) для компьютеров плоскости управления в вашем кластере.Если вы решили использовать вычислительные машины RHEL в своем кластере, вы несете ответственность за управление и обслуживание всего жизненного цикла операционной системы. Вы должны выполнять обновления системы, применять исправления и выполнять все другие необходимые задачи.

Поскольку удаление OpenShift Container Platform с компьютера в кластере требует уничтожения операционной системы, вы должны использовать выделенное оборудование для любых компьютеров RHEL, которые вы добавляете в кластер.

Подкачка памяти отключена на всех компьютерах RHEL, которые вы добавляете в свой кластер OpenShift Container Platform. Вы не можете включить память подкачки на этих машинах.

Все вычислительные машины RHEL необходимо добавить в кластер после инициализации плоскости управления.

Системные требования для вычислительных узлов RHEL

Хосты вычислительных машин Red Hat Enterprise Linux (RHEL) в вашей среде OpenShift Container Platform должны соответствовать следующим минимальным спецификациям оборудования и системным требованиям:

У вас должна быть активная подписка на OpenShift Container Platform в вашей учетной записи Red Hat. Если нет, обратитесь к торговому представителю для получения дополнительной информации.

Производственные среды должны предоставлять вычислительные машины для поддержки ожидаемых рабочих нагрузок. Как администратор кластера, вы должны рассчитать ожидаемую рабочую нагрузку и добавить около 10% накладных расходов.

Для рабочих сред выделите достаточно ресурсов, чтобы сбой хоста узла не повлиял на вашу максимальную емкость.

Каждая система должна соответствовать следующим требованиям к оборудованию:

Физическая или виртуальная система или экземпляр, работающий в общедоступной или частной IaaS.

Базовая ОС: RHEL 8.4 или 8.5 с «минимальной» установкой.

Добавление вычислительных машин RHEL 7 в кластер OpenShift Container Platform не поддерживается.

Если у вас есть вычислительные машины RHEL 7, которые ранее поддерживались в предыдущей версии OpenShift Container Platform, вы не можете обновить их до RHEL 8. Необходимо развернуть новые хосты RHEL 8, а старые хосты RHEL 7 следует удалить. Дополнительные сведения см. в разделе «Удаление узлов».

Самый последний список основных функций, которые устарели или были удалены в OpenShift Container Platform, см. в разделе Устаревшие и удаленные функции примечаний к выпуску OpenShift Container Platform.

Если вы развернули OpenShift Container Platform в режиме FIPS, вы должны включить FIPS на компьютере RHEL перед его загрузкой. См. Установка системы RHEL 8 с включенным режимом FIPS в документации RHEL 8.

Использование криптографических библиотек с проверкой FIPS/модулей в процессе поддерживается только в развертываниях OpenShift Container Platform на архитектуре

x86_64.

NetworkManager 1.0 или выше.

1 виртуальный ЦП.

Минимум 8 ГБ ОЗУ.

Минимум 15 ГБ свободного места на жестком диске для файловой системы, содержащей

/вар/.Минимум 1 ГБ свободного места на жестком диске для файловой системы, содержащей

/usr/local/bin/.Минимум 1 ГБ свободного места на жестком диске для файловой системы, содержащей временный каталог.

Временный системный каталог определяется в соответствии с правилами, определенными в модуле tempfile стандартной библиотеки Python.

Каждая система должна соответствовать любым дополнительным требованиям вашего системного провайдера. Например, если вы установили свой кластер на VMware vSphere, ваши диски должны быть настроены в соответствии с его рекомендациями по хранению и

disk.enableUUID=trueАтрибут должен быть установлен.Каждая система должна иметь возможность доступа к конечным точкам API кластера, используя DNS-разрешаемые имена хостов. Любой имеющийся контроль доступа к сетевой безопасности должен разрешать системе доступ к конечным точкам службы API кластера.

Дополнительные ресурсы

Удаление узлов

Управление запросами на подпись сертификата

Поскольку ваш кластер имеет ограниченный доступ к автоматическому управлению машинами при использовании предоставляемой вами инфраструктуры, вы должны предоставить механизм утверждения запросов на подпись сертификата кластера (CSR) после установки.

kube-controller-managerутверждает только CSR клиента kubelet. Утверждающий компьютерне может гарантировать действительность обслуживающего сертификата, запрошенного с использованием учетных данных kubelet, поскольку он не может подтвердить, что правильный компьютер выдал запрос. Вы должны определить и внедрить метод проверки действительности kubelet, обслуживающего запросы сертификатов, и их утверждения.Подготовка машины к запуску playbook

Прежде чем добавлять вычислительные машины, использующие Red Hat Enterprise Linux (RHEL) в качестве операционной системы, в кластер OpenShift Container Platform 4.10, необходимо подготовить машину RHEL 7 или 8 для запуска Ansible playbook, который добавляет новый узел в кластер. Эта машина не является частью кластера, но должна иметь к нему доступ.

Предпосылки

Процедура

Убедитесь, что файл

kubeconfigдля кластера и программа установки, которую вы использовали для установки кластера, находятся на компьютере RHEL.Один из способов добиться этого — использовать тот же компьютер, который вы использовали для установки кластера.

Настройте компьютер для доступа ко всем хостам RHEL, которые вы планируете использовать в качестве вычислительных компьютеров. Вы можете использовать любой метод, разрешенный вашей компанией, включая бастион с SSH-прокси или VPN.

Настройте пользователя на компьютере, на котором вы запускаете playbook, который имеет доступ SSH ко всем хостам RHEL.

Если вы используете аутентификацию на основе ключа SSH, вы должны управлять ключом с помощью агента SSH.

Если вы еще этого не сделали, зарегистрируйте машину в RHSM и прикрепите к ней пул с подпиской

OpenShift:

Зарегистрируйте машину в RHSM:

# регистрация менеджера подписки --username=<имя_пользователя> --password=<пароль>Получить последние данные подписки из RHSM:

# обновление менеджера подпискиСписок доступных подписок:

# список менеджеров подписок --доступен --matches '*OpenShift*'В выходных данных предыдущей команды найдите идентификатор пула для подписки OpenShift Container Platform и прикрепите его:

# менеджер подписки прикрепить --pool=Включить репозитории, необходимые для OpenShift Container Platform 4.

10:

В системе RHEL 8 выполните следующую команду:

# репозиторий менеджера подписки \ --enable="rhel-8-for-x86_64-baseos-rpms" \ --enable="rhel-8-for-x86_64-appstream-rpms" \ --enable="ansible-2.9-for-rhel-8-x86_64-rpm" \ --enable="rhocp-4.10-for-rhel-8-x86_64-rpm"В системе RHEL 7 выполните следующую команду:

# репозиторий менеджера подписки \ --enable="rhel-7-server-rpms" \ --enable="rhel-7-server-extras-rpms" \ --enable="rhel-7-server-ansible-2.9-rpms" \ --enable="rhel-7-server-ose-4.10-rpms"

Начиная с OpenShift Container Platform 4.10.23, запуск Ansible playbooks на RHEL 7 устарел и предлагается только с целью обновления существующих установок. Начиная с OpenShift Container Platform 4.11, книги воспроизведения Ansible предоставляются только для RHEL 8.

Установите необходимые пакеты, включая

openshift-ansible:# yum install openshift-ansible openshift-clients jqПакет

openshift-ansibleсодержит утилиты программы установки и извлекает другие пакеты, необходимые для добавления вычислительного узла RHEL в ваш кластер, такие как Ansible, плейбуки и соответствующие файлы конфигурации.

openshift-клиентовобеспечиваютocCLI, а пакетjqулучшает отображение вывода JSON в командной строке.Подготовка вычислительного узла RHEL

Перед добавлением компьютера Red Hat Enterprise Linux (RHEL) в кластер OpenShift Container Platform необходимо зарегистрировать каждый хост в Red Hat Subscription Manager (RHSM), подключить активную подписку OpenShift Container Platform, и включите необходимые репозитории.

На каждом хосте зарегистрируйтесь в RHSM:

# регистрация менеджера подписки --username=<имя_пользователя> --password=<пароль>Получить последние данные подписки из RHSM:

# обновление менеджера подпискиСписок доступных подписок:

# список менеджеров подписок --доступен --matches '*OpenShift*'В выходных данных предыдущей команды найдите идентификатор пула для подписки OpenShift Container Platform и прикрепите его:

# менеджер подписки прикрепить --pool=Отключить все репозитории yum:

Отключить все включенные репозитории RHSM:

# репозиторий менеджера подписки --disable="*"Перечислите оставшиеся репозитории yum и запишите их имена под

repo id, если есть:# ням реполистИспользуйте

yum-config-manager, чтобы отключить остальные репозитории yum:# yum-config-manager --disableВ качестве альтернативы можно отключить все репозитории:

# yum-config-manager --disable \*Обратите внимание, что это может занять несколько минут, если у вас большое количество доступных репозиториев

Включить только репозитории, необходимые для OpenShift Container Platform 4.

10:

# репозиторий менеджера подписки \ --enable="rhel-8-for-x86_64-baseos-rpms" \ --enable="rhel-8-for-x86_64-appstream-rpms" \ --enable="rhocp-4.10-for-rhel-8-x86_64-rpms" \ --enable="fast-datapath-for-rhel-8-x86_64-rpm"Остановить и отключить firewalld на хосте:

# systemctl отключить --now firewalld.service

Вы не должны включать firewalld позже. Если вы это сделаете, вы не сможете получить доступ к журналам OpenShift Container Platform на рабочем месте.

Добавление вычислительной машины RHEL в кластер

Вы можете добавить вычислительные машины, использующие Red Hat Enterprise Linux в качестве операционной системы, в кластер OpenShift Container Platform 4.10.

Предварительные условия

Процедура

Выполните следующие действия на машине, подготовленной для запуска playbook:

Создайте файл инвентаризации Ansible с именем

/<путь>/inventory/hosts, который определяет хосты вашей вычислительной машины и необходимые переменные:[все:вары] ansible_user=root (1) #ansible_become=Истина (2) openshift_kubeconfig_path="~/.kube/config" (3) г. [new_workers] (4) mycluster-rhel8-0.example.com mycluster-rhel8-1.example.com

1 Укажите имя пользователя, который запускает задачи Ansible на удаленных вычислительных машинах. 2 Если вы не укажете rootдляansible_user, вы должны установить дляansible_becomeзначениеTrueи назначить пользователю разрешения sudo.3 Укажите путь и имя файла kubeconfigдля вашего кластера.4 Перечислите все машины RHEL для добавления в ваш кластер. Вы должны указать полное доменное имя для каждого хоста. Это имя является именем хоста, которое кластер использует для доступа к машине, поэтому задайте правильное общедоступное или частное имя для доступа к машине. Перейдите в каталог Ansible playbook:

$ cd /usr/share/ansible/openshift-ansibleЗапустить плейбук:

$ ansible-playbook -i //inventory/hosts playbooks/scaleup.yml (1)

1 Для <путь>укажите путь к созданному вами файлу инвентаризации Ansible.Обязательные параметры для файла узлов Ansible

Перед добавлением вычислительных машин Red Hat Enterprise Linux (RHEL) в кластер необходимо определить следующие параметры в файле узлов Ansible.

Параметр Описание Значения

ansible_userПользователь SSH, который разрешает аутентификацию на основе SSH без ввода пароля.

Если вы используете аутентификацию на основе ключа SSH, вы должны управлять ключом с помощью агента SSH.

Имя пользователя в системе. Значение по умолчанию —

root.

ansible_becomeЕсли значения

ansible_userне root, вы должны установитьansible_becomeнаTrue, а пользователь, указанный вами какansible_user, должен быть настроен для доступа sudo без пароля.

Правда. Если значение не равноTrue, не указывайте и не определяйте этот параметр.

openshift_kubeconfig_pathУказывает путь и имя файла к локальному каталогу, содержащему файл

kubeconfigдля вашего кластера.Путь и имя файла конфигурации.

Необязательно: удаление вычислительных машин RHCOS из кластера

После добавления вычислительных машин Red Hat Enterprise Linux (RHEL) в кластер можно при желании удалить вычислительные машины Red Hat Enterprise Linux CoreOS (RHCOS), чтобы освободить Ресурсы.

Предпосылки

Процедура

Просмотрите список машин и запишите имена узлов вычислительных машин RHCOS:

$ oc получить узлы -o широкийДля каждой вычислительной машины RHCOS удалите узел:

Пометьте узел как незапланированный, выполнив команду

oc adm Cordon:$ oc adm Cordon(1)

1 Укажите имя узла одной из вычислительных машин RHCOS. Слить все поды с ноды:

$ oc adm сток--force --delete-emptydir-data --ignore-daemonsets (1)

1 Укажите имя узла вычислительной машины RHCOS, которую вы изолировали. Удалить узел:

$ oc удалить узлы(1)

1 Укажите имя узла вычислительной машины RHCOS, которую вы слили. Просмотрите список вычислительных машин, чтобы убедиться, что остались только узлы RHEL:

$ oc получить узлы -o широкийУдалите машины RHCOS из балансировщика нагрузки для вычислительных машин вашего кластера. Вы можете удалить виртуальные машины или повторно создать образ физического оборудования для вычислительных машин RHCOS.

Добавление вычислительных машин RHCOS в кластер OpenShift Container Platform

Вы можете добавить дополнительные вычислительные машины Red Hat Enterprise Linux CoreOS (RHCOS) в свой кластер OpenShift Container Platform на «голом железе».

Прежде чем добавлять дополнительные вычислительные машины в кластер, установленный в инфраструктуре «голого железа», необходимо создать для него машины RHCOS. Вы можете использовать ISO-образ или сетевую загрузку PXE для создания машин.

Предпосылки

Вы установили кластер на голое железо.

У вас есть установочный носитель и образы Red Hat Enterprise Linux CoreOS (RHCOS), которые вы использовали для создания кластера. Если у вас нет этих файлов, вы должны получить их, следуя инструкциям в процедуре установки.

Создание дополнительных машин RHCOS с помощью образа ISO

Вы можете создать больше вычислительных машин Red Hat Enterprise Linux CoreOS (RHCOS) для своего кластера на «голом железе», используя образ ISO для создания машин.

Предпосылки

Процедура

Используйте файл ISO для установки RHCOS на большее количество вычислительных машин. Используйте тот же метод, который вы использовали при создании машин до установки кластера:

.

После загрузки экземпляра нажмите клавишу

TABилиE, чтобы отредактировать командную строку ядра.Добавьте параметры в командную строку ядра:

coreos.inst.install_dev=sda (1) г. coreos.inst.ignition_url=http://example.com/worker.ign (2)

1 Укажите блочное устройство системы для установки. 2 Укажите URL-адрес файла конфигурации Ignition вычислений. Поддерживаются только протоколы HTTP и HTTPS. Нажмите

Введитедля завершения установки. После установки RHCOS система перезагружается. После перезагрузки система применяет указанный вами файл конфигурации Ignition.Продолжайте создавать дополнительные вычислительные машины для своего кластера.

Создание дополнительных машин RHCOS с помощью загрузки PXE или iPXE

Вы можете создать больше вычислительных машин Red Hat Enterprise Linux CoreOS (RHCOS) для своего кластера на «голом железе», используя загрузку PXE или iPXE.

Предпосылки

Получите URL-адрес файла конфигурации Ignition для вычислительных машин вашего кластера. Вы загрузили этот файл на свой HTTP-сервер во время установки.

Получите URL-адреса ISO-образа RHCOS, сжатого металлического BIOS,

ядраифайлов initramfs, которые вы загрузили на свой HTTP-сервер во время установки кластера.У вас есть доступ к инфраструктуре загрузки PXE, которую вы использовали для создания машин для своего кластера OpenShift Container Platform во время установки. Машины должны загружаться со своих локальных дисков после установки на них RHCOS.

Если вы используете UEFI, у вас есть доступ к файлу

grub.conf, который вы изменили во время установки OpenShift Container Platform.Процедура

Подтвердите правильность установки PXE или iPXE для образов RHCOS.

Эта конфигурация не обеспечивает доступ к последовательной консоли на компьютерах с графической консолью.

Чтобы настроить другую консоль, добавьте один или несколько аргументов

console=вДОБАВИТЬстроку. Например, добавьтеconsole=tty0 console=ttyS0, чтобы установить первый последовательный порт ПК в качестве основной консоли, а графическую консоль — в качестве дополнительной консоли. Для получения дополнительной информации см. Как настроить последовательный терминал и/или консоль в Red Hat Enterprise Linux?.Эта конфигурация не обеспечивает доступ к последовательной консоли на компьютерах с графической консолью. Чтобы настроить другую консоль, добавьте один или несколько аргументов

console=в ядро 9.1153 строка. Например, добавьтеconsole=tty0 console=ttyS0, чтобы установить первый последовательный порт ПК в качестве основной консоли, а графическую консоль — в качестве дополнительной консоли. Для получения дополнительной информации см. Как настроить последовательный терминал и/или консоль в Red Hat Enterprise Linux?.

Используйте инфраструктуру PXE или iPXE для создания необходимых вычислительных машин для вашего кластера.

Утверждение запросов на подпись сертификата для ваших машин

При добавлении машин в кластер для каждой добавленной машины создаются два ожидающих запроса на подпись сертификата (CSR). Вы должны подтвердить, что эти CSR утверждены, или, при необходимости, утвердить их самостоятельно. Запросы клиента должны быть одобрены первыми, а затем запросы сервера.

Предпосылки